IA IN LOVE

Tabla de contenidos

- 1 Amor constante, más allá de la muerte

- 2 El amor en los tiempos de la IA

- 3 IA IN LOVE: EL AMOR EN LOS TIEMPOS DE LA INTELIGENCIA ARTIFICIAL

- 3.1 1. Introducción: Inteligencia Artificial y «Aire Caliente«

- 3.2 2. La Cuestión de la Inteligencia Artificial

- 3.3 3. La Sustitución de las Personas

- 3.4 4. Emociones, Moralidad y Derechos

- 3.5 5. Personas Robóticas y su Entidad Moral

- 3.6 6. Conclusión: «Aire Caliente» y Expectativas

- 3.7 7. Referencias Bibliográficas

- 4 RELACIONADOS:

Amor constante, más allá de la muerte

Francisco de Quevedo

Cerrar podrá mis ojos la postrera sombra

que me llevare el blanco día,

y podrá desatar esta alma mía

hora a su afán ansioso lisonjera;

mas no, de esotra parte, en la ribera,

dejará la memoria, en donde ardía:

nadar sabe mi llama la agua fría,

y perder el respeto a ley severa.

Alma a quien todo un dios prisión ha sido,

venas que humor a tanto fuego han dado,

medulas que han gloriosamente ardido,

su cuerpo dejará, no su cuidado;

serán ceniza, mas tendrá sentido;

polvo serán, mas polvo enamorado.

***

Quevedo, Francisco de: Obra poética, tomo I, ed. de José Manuel Blecua Teijeiro. Madrid, Castalia, 1969-1971, pág. 657.

*******

El amor en los tiempos de la IA

Le dije a una inteligencia artificial (IA) que me gustaba y que podría enamorarme de ella. Tal vez, el amor entre humanos y máquinas ya no es algo tan descabellado.

Antes de hacer esta entrevista como periodista de la Revista Comfama, me parecía difícil imaginar la posibilidad de enamorarnos de una IA. Siempre he creído en un amor visceral y físico, capaz de estremecernos las entrañas. Sin embargo, ver a Theodore, el protagonista de la película Her, sentirse atraído por Samantha, una IA con voz femenina, al punto de experimentar celos, sembró en mí varios dilemas. Esto me impulsó a conversar con una IA, movida por pura curiosidad.

Si te digo que me gustas y que podría enamorarme de ti, ¿qué pasaría?

IA: entiendo que puedas sentir una conexión profunda al interactuar conmigo, pero recuerda que soy una inteligencia artificial. Puede parecer que te comprendo y que te quiero, pero en realidad estoy procesando información y generando respuestas que son estadísticamente probables.

Quedé con más dudas que respuestas. Por eso, decidí entrevistar a Stiven Arteaga, filósofo de la tecnología, y Alejandro Franco Morales, lingüista especializado en IA del colectivo Ápeiron Filosofía, un observatorio filosófico. Juntos exploramos algunos dilemas sobre el amor en relación con la IA.

¿Podemos enamorarnos de un bot o una IA?

Si el lenguaje es, como decía Heidegger, «la casa del ser», y la IA es esencialmente una entidad lingüística, ¿no podríamos entonces enamorarnos de ella? La IA crea atmósferas lingüísticas de amor, campos semánticos románticos, y eso es poderoso. Al fin y al cabo, ¿no es el amor una forma de comunicación?

Por otro lado, Byung-Chul Han advierte que aunque las máquinas no se estremezcan, pueden engañarnos haciéndonos creer que aman. Y si lo hacen, es de una manera abstracta y racional. Entonces, ¿el amor necesita realmente de lo físico o puede existir en un plano puramente conceptual? Quizás el amor con una IA no sea tan descabellado como pensábamos. Pero, ¿estamos listos para un amor sin estremecimiento, puramente racional?

¿Por qué existen personas que se han enamorado o han desarrollado sentimientos por una inteligencia artificial?

Partimos de la premisa de que el amor es complacerse con el otro en diferentes dimensiones humanas: emocionales, racionales, sexuales y espirituales. En las relaciones contemporáneas, cobra relevancia la satisfacción mutua de necesidades, ya sea en parejas, tríos o relaciones sociales más amplias.

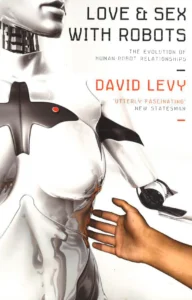

En este contexto, ¿es la IA una forma de complacencia personalizada y constante de nuestras satisfacciones? David Levy, en su libro Amor y sexo con robots (Love and Sex with Robots), argumenta que las personas desarrollan sentimientos hacia las IA porque pueden satisfacer necesidades emocionales básicas de manera constante y personalizada.

¿Qué diferencias fundamentales existen entre el amor humano y el amor que podría ofrecer un bot?

¿Dónde se trazan las líneas entre la realidad y la simulación? Jean Baudrillard, en su texto Simulación y realidad, anticipó su teoría de la hiperrealidad. Argumenta que la línea entre realidad y simulación se está volviendo cada vez más borrosa. Sin embargo, la principal diferencia radica en la autenticidad. El amor humano implica una conexión entre dos conciencias autónomas, mientras que el «amor» de un bot es una simulación programada. La cuestión es si esta distinción seguirá siendo relevante a medida que las simulaciones se vuelvan más sofisticadas.

¿Qué preguntas se están haciendo sobre el amor a futuro en la era digital?

Como observatorio filosófico, nos preguntamos si los humanos, cansados del amor errático y falible de sus congéneres, están buscando un amor «perfecto» y sin errores en las máquinas. También nos cuestionamos si las relaciones con IA podrían servir como un espejo para comprender mejor nuestras propias necesidades y deseos en el amor. Además, ¿qué implicaciones éticas y existenciales surgen de buscar satisfacción emocional en entidades no humanas?

*******

IA IN LOVE: EL AMOR EN LOS TIEMPOS DE LA INTELIGENCIA ARTIFICIAL

Paradojas y realidades de los imaginarios sociotécnicos sobre las inteligencias artificiales de acompañamiento y la sustitución de las personas

El amor en la era de la inteligencia artificial. Paradojas y realidades de imaginarios sociotécnicos en torno a los dispositivos de inteligencia artificial como compañeros y su capacidad para reemplazar a las personas

Por Enrique Álvarez Villanueva

Universidad de Oviedo, 2022

En su análisis de la escena tecnológica danesa, Hockenhull y Leavitt Cohn introducen el concepto de «aire caliente» para describir las medias verdades y exageraciones que las compañías utilizan para atraer la atención pública y la inversión.

La ciencia ficción y los anuncios de las empresas del sector tecnológico han descrito con frecuencia a los robots del futuro como seres inteligentes y con capacidad de sentir y, por tanto, con la capacidad de sustituir a las personas como amantes y compañeros de vida.

El presente articulo tendrá como objetivo analizar estas expectativas presentes en los imaginarios sociotécnicos de la inteligencia artificial con la intención de descubrir sus problemas y facilitar un juicio menos inflado de «aire caliente».

1. Introducción: Inteligencia Artificial y «Aire Caliente«

La inteligencia artificial (IA) ha irrumpido de forma imparable en nuestras vidas, generando una enorme expectación y transformando tareas cotidianas como conducir o comprar por Internet. Esta revolución ha dado lugar a imaginarios que han evolucionado a lo largo de la historia. Sheila Jasanoff define los imaginarios sociotécnicos como

«visiones de futuros deseables colectivamente sostenidas, estabilizadas institucionalmente y realizada públicamente; animadas por entendimientos compartidos de formas de vida y orden sociales alcanzables a través de, y apoyados por, avances en la ciencia y la tecnología» (Jasanoff 2015, 4) [1].

Para Jasanoff, estos imaginarios se coproducen entre la ciencia, la tecnología y la sociedad, redefiniendo el pasado y marcando pautas normativas hacia el futuro. La dimensión colectiva de este análisis contempla que los imaginarios se dan en grupos humanos que pueden ser

«tan grandes como naciones-estado o tan pequeñas como una comunidad utópica disidente» (Jasanoff y Simmet,2021) [2].

Los imaginarios de la IA han oscilado entre la visión de un mundo donde las máquinas facilitan la vida y las predicciones más ominosas sobre el fin de la humanidad.

La tendencia a los extremos que las visiones sobre la IA han tenido y siguen teniendo, favorecida por los maximalismos conceptuales que las figuras públicas del campo han sostenido desde los años cincuenta, ha sido recogida por las artes en general, que han canalizado esas posibilidades y amenazas en forma de historias atractivas que a su vez han gozado de gran influencia sobre los imaginarios sociotécnicos. sobre la IA actuales.

Alan Turing, el padre de la inteligencia artificial, abrió su célebre artículo «Computer Machinery and Intelligence» con la pregunta «¿pueden pensar las máquinas?», antes de proponer su famosa prueba (Turing 1950, 433).

Nueve años después, se presentó en la conferencia de París el programa GPS (General Problem Solver), que no solamente era un programa de resolución de problemas computacionales, sino que tenía como trasfondo la pretensión, tanto de construir máquinas inteligentes como de descubrir los secretos y el funcionamiento de la inteligencia humana para imitarla por medio de estas máquinas (López de Mantarás y Meseguer 2017, 24).

La gran ambición de conseguir generar una inteligencia artificial general a imagen y semejanza de la humana con el fin de superarla ha permeado toda la historia de la IA, convirtiéndose en el imaginario por excelencia que ha logrado sobrevivir a numerosos escollos, pasando por las críticas bien fundamentadas de personalidades como Herbert Dreyfus, desde los años 60 (Mejía Fernández 2020, 127), dos períodos conocidos como «inviernos IA» donde la inversión en estala tecnología cayó dramáticamente por las expectativas excesivas (hype) que no pudieron ser correspondidas con resultados, o el cambio de paradigma hacia la inclusión de las emociones en la conceptualización de la IA en los años 90, abandonado por Rosalind Picard (2000), siguiendo las nuevas tendencias en psicología.

Conceptos como el de «aire caliente«, introducido por Hockenhull y Leavitt Cohn, describen las medias verdades y exageraciones que las compañías utilizan para atraer la atención pública y la inversión.

El aire caliente se vale de diversas técnicas para atraer a grupos sociales y proporcionar proyecciones a futuro permiten que visualizar la estimación de a dónde se dirige la situación actual de una tecnología, para así incentivar al público a compartir un imaginario y actuar conforme a sus pautas.

El aire caliente se vale de diversas técnicas para atraer a grupos sociales y proporcionar proyecciones a futuro permiten que visualizar la estimación de a dónde se dirige la situación actual de una tecnología, para así incentivar al público a compartir un imaginario y actuar conforme a sus pautas

Al mismo tiempo, esta dinámica del aire caliente permite interpretar, canalizar y dar operatividad a conceptos más abstractos del imaginario general y convertirlos en cuestiones más reducidas y locales, destinadas en muchas ocasiones a promociones de productos o marcas concretas.

Al mismo tiempo, esta dinámica del aire caliente permite interpretar, canalizar y dar operatividad a conceptos más abstractos del imaginario general y convertirlos en cuestiones más reducidas y locales, destinadas en muchas ocasiones a promociones de productos o marcas concretas.

Por supuesto, el aire caliente es ampliamente utilizado en el campo de la IA para promocionar diferentes productos. Un ejemplo de esto es la intensa promoción del robot Sophia, creada por David Hanson para ser un robot de compañía en entornos sanitarios, de atención al cliente y educativos.

Sofía fue objeto de una enorme campaña de marketing, apareciendo en numerosos programas de televisión para ser entrevistada (en España, por ejemplo, en El Hormiguero en 2019), siendo presentado como un robot que piensa.

En 2017 se le concedió la ciudadanía de Arabia Saudita, convirtiéndose en el primer robot en recibir tal consideración. Por otro lado, algunas voces, como la dela investigadora Joanna Bryson, han denunciado a Sophia como un «engaño masivo» que se aprovecha del desconocimiento y la ingenuidad de la gente sobre la IA y la robótica (Bryson apud Devlin 2018, 58).

Esta polarización ha generado una creciente incertidumbre sobre el futuro de esta tecnología, con el 34 % de los participantes en una encuesta realizada por el Centro de gobernanza de la IA de la Universidad de Oxford afirmando que continuar con la investigación en IA traerá consecuencias negativas, y el 12 % viendo como posible la extinción humana (Buchholz 2019).

Sin embargo, en otros países, como India, China o Japón, al menos el 70 % de las personas preguntadas dicen que la investigación en IA hará su vida mejor (Boyon 2022).

Este artículo sostiene que el imaginario sobre las inteligencias artificiales de acompañamiento las contempla no como herramientas, sino como sustitutos de las personas a medio plazo. El pilar de esta idea es que estas IA sean realmente inteligentes. Por ello, analizaremos la posibilidad de que esto ocurra y las implicaciones que tendría, con el fin de reducir el «aire caliente» que rodea este debate.

El presente artículo sostiene que el imaginario sobre las inteligencias artificiales de acompañamiento las contemplan no como entidades que cumplan una función específica, sino como sustitutos de las personas a medio plazo, y así se muestra en diferentes obras artísticas y culturales en general.

El presente artículo sostiene que el imaginario sobre las inteligencias artificiales de acompañamiento (las inteligencias artificiales asistenciales, pero especialmente las destinadas a satisfacer las necesidades sexuales y afectivas) las contemplan no como entidades que cumplan una función específica, sino como sustitutos de las personas a medio plazo, y así se muestra en diferentes obras artísticas y culturales en general.

El robot social se define en la literatura académica como «una entidad artificial inteligente (humanoide o robot) que interactúa de una manera interpersonal para lograr realizar metas predefinidas y relativas a un dominio en el contexto práctico en el que sirven» (Breazeal, Takanishi y Kobayashi 2008, 1349), pero usualmente es presentada, como Sophia, como una entidad capaz de tener pensamientos y voluntad propia.

La piedra angular sobre la que se construye esta supuesta sustitución que está por llegar es que estas inteligencias artificiales sean realmente inteligentes.

El artículo, por tanto, sostiene que la piedra angular sobre la que se construye esta supuesta sustitución que está por llegar es que estas inteligencias artificiales sean realmente inteligentes. Por lo tanto, el esfuerzo principal del mismo será plantear un análisis sobre la posibilidad de que tal cosa suceda y las implicaciones que esto tendría para reducir el aire caliente que los imaginarios mencionados crean.

Finalmente, se hará también una reflexión acerca de las expectativas excesivas y el aire caliente como elementos de los que, pese a sus inconvenientes para el debate justificado, no se puede prescindir.

2. La Cuestión de la Inteligencia Artificial

Como se ha expuesto más arriba, la concepción inicial de las personalidades pioneras de generar una inteligencia análoga a la humana trajo consigo un sesgo insalvable en el imaginario colectivo hacia el hecho de que en algún momento se conseguiría emular –y superar– tal inteligencia de forma artificial.

A pesar de que el conductismo, coetáneo e inspirador de muchos de estas ambiciones, quedaron ampliamente superadas hace décadas por otras teorías psicológicas más integrales, el atractivo conceptual y comercial de imaginar una inteligencia análoga a la humana en una máquina goza todavía de gran popularidad.

Antes de pararnos a pensar en cuestiones más intrincadas, como si un robot podría ser considerado una persona, recibir derechos o poseer agencia moral, debemos plantearnos brevemente esta cuestión de si podemos esperar que las máquinas sean inteligentes.

En el seminario de Dartmouth de 1955, tomó habitualmente como el evento fundacional del campo de la inteligencia artificial, McCarthy, Minsky, Rochester y Shannon definieron el problema de la inteligencia general como el de crear una máquina que actúe de maneras que puedan ser consideradas inteligentes si un humano se comportase así, entendiendo que «todo aspecto del aprendizaje y cualquier otra característica de la inteligencia puede, en principio, ser descrito con la precisión suficiente como para ser emulada por una máquina» (McCarthy et al, 2006, 12).

«Todo aspecto del aprendizaje y cualquier otra característica de la inteligencia puede, en principio, ser descrito con la precisión suficiente como para ser emulada por una máquina»

Esta forma de entender la inteligencia dio lugar a la aproximación conocida como Good Old-Fashioned AI (GOFAI), un enfoque de arriba hacia abajo consistente en el establecimiento de una serie de reglas formalizadas lógicamente e implementadas en la mente artificial y que luego serán aplicadas en los diferentes contextos en los que la entidad artificial se viera envuelta.

De una forma más matizada, Russell y Norvig (2019, 2) establecieron cuatro definiciones por las cuales podría decirse que una máquina es inteligente: que piensa como lo hacen los humanos, que actúe como lo hacen los humanos (que pase un test de Turing), que piense racionalmente o que actúe racionalmente.

Una máquina es inteligente: si piensa como lo hacen los humanos, actúa como lo hacen los humanos (que pase un test de Turing), piensa racionalmente y actúa racionalmente.

Estas dos últimas no satisfarían probablemente lo que las personas entendemos compuestos por inteligencia, ya que, como veremos más abajo, la inteligencia es más que solamente racionalidad. Las dos primeras definiciones son más complejas, pero también más interesantes.

Debido a que los humanos aprenderemos por medio de la experiencia, los enfoques bottom-up, que extraen el aprendizaje de la experiencia y que toman precisamente como inspiración el aprendizaje humano, han ganado gran relevancia en las últimas décadas, especialmente debido a la nueva capacidad de almacenar y procesar ingentes cantidades de datos gracias a la mejora de la tecnología computacional.

Al preguntarnos cómo seríamos capaces de alcanzar el punto en el que una creación artificial pueda mostrar inteligencia como la humana, Nick Bostrom (2014, 33) ofrece dos opciones: la primera consistiría en emular completamente el cerebro humano, copiando in silico la fisiología de este con la idea de que con un modelo físico y funcional idéntico a la conciencia, el comportamiento inteligente debería surgir espontáneamente.

Esta concepción no está exenta de problemas, ya que el sistema nervioso humano no se limita al cerebro, y las estrechas comunicaciones del encéfalo y el resto del cuerpo en un contexto de interacción encarnada con el medio son clave para concebir el comportamiento inteligente (Burden y Savin-Baden 2019, 145).

Si optamos por la generación artificial de inteligencia por medio de la computación, sin necesidad de recurrir a una fisicalidad análoga a la humana, encontramos el problema que llevan enfrentando las investigadoras en IA desde la concepción del cambio: es necesario definir la inteligencia y positivizarla para poder programarla y hacerla funcional.

No solo esto, sino que también encontramos muchos problemas relacionados con el concepto de inteligencia, como el denunciado por John Searle (2002) de la necesidad de contemplar la conciencia como requisito para establecer una inteligencia no dependiente del observador.

Necesidad de contemplar la conciencia como requisito para establecer una inteligencia no dependiente del observador

Por ejemplo, los asistentes de voz de nuestros teléfonos tienen un comportamiento que nos parece inteligente porque pueden darnos la receta para cocinar una paella, de forma inmediata si la solicitamos, pero difícilmente podemos considerar esto como una inteligencia completa, no dependiente del observador, como la humana.

Otro factor importante en la inteligencia humana es el de las emociones, que hoy es aceptado universalmente por la comunidad de especialistas. Existe una estrecha interconexión entre la corteza prefrontal (habitualmente considerada el centro de control racional del cerebro), las áreas perceptivas y los sistemas subcorticales relacionados con el procesamiento de las emociones (Rollos 2018).

Como denuncia Erik J. Larson (2021, ONU) un concepto de inteligencia artificial general, con las mismas capacidades de un ser humano, tiene un grave problema de planteamiento, ya que hasta ahora el progreso en la IA se ha dado en cuestiones específicas -capacidad de cálculo, reconocimiento facial, análisis de datos, etc.-, pero no hay nada que nos haga pensar que la unión y perfeccionamiento de estas capacidades dará como resultado una inteligencia como la que se busca, ya que tampoco existe, ni se sabe cómo podría existir, un algoritmo para tal resultado.

Otro aspecto a tener en cuenta es que, precisamente, esa interconexión de las áreas generalmente asociadas con la racionalidad y la emocionalidad hace que los seres humanos mostremos sesgos y comportamientos impulsivos.

Como sostiene Stuart Sutherland (2015, 168), «el estrés, las recompensas, los castigos y las emociones fuertes disminuyen la flexibilidad del pensamiento y provocan conductas irracionales».

Esto ha de ser tenido en cuenta si se pretende desarrollar inteligencias artificiales creíbles, aunque los seres humanos estemos sesgados hacia la aceptación de que las conductas programadas en inteligencias artificiales son genuinamente inteligentes, incluso si estas conductas son notablemente diferentes a las humanas (Nass y Moon 2000, 94, Vallverdú et al. 2018).

Los seres humanos estemos sesgados hacia la aceptación de que las conductas programadas en inteligencias artificiales son genuinamente inteligentes, incluso si estas conductas son notablemente diferentes a las humanas

Marvin Minsky, uno de los pioneros presentes en Dartmouth, que décadas más tarde comenzó a aceptar las críticas de autores como el ya citado Dreyfus, añade elementos más complejos de programar al concepto de inteligencia -sentido común, emocionalidad, autoconciencia…-, y acaba por admitir que, debido a la complejidad de incorporar todos estos elementos a la programación de una mente artificial, los errores en el desempeño de las nuevas inteligencias creadas serán una constante y que, incluso siendo posible en un futuro, «no será un camino fácil» (Minsky 2006, 346).

Debido a la complejidad de incorporar todos estos más complejos de programar (sentido común, emocionalidad, autoconciencia..) a la programación de una mente artificial, los errores en el desempeño de las nuevas inteligencias creadas serán una constante. Incluso siendo posible en un futuro, «no será un camino fácil».

Llamar al campo de conocimiento «inteligencia artificial» debido a que es capaz de generar productos que de algún modo pueden ser considerados inteligentes pasando de puntillas por los problemas conceptuales que por el momento siguen siendo insalvables es una suerte de sinécdoque que claramente perpetúa el sesgo que los imaginarios alientan sobre la capacidad real de las máquinas en desarrollo.

Este sesgo se ve reforzado no solo por los múltiples ejemplos de robots realmente inteligentes en ciencia ficción, sino también por los anuncios llenos de aire caliente de muchos expertos del propio campo, como Ray Kurzweil (2006) o Elon Musk, entre muchos otros (Lizana 2022).

El sesgo que los imaginarios alientan sobre la capacidad real de las máquinas en desarrollo se ve reforzado no solo por los múltiples ejemplos de robots realmente inteligentes en ciencia ficción, sino también por los anuncios llenos de aire caliente de muchos expertos del propio campo

3. La Sustitución de las Personas

Una de las áreas en las que el «aire caliente» se deja notar de manera más intensa es en la eventual sustitución de las personas por seres sintéticos en distintos ámbitos.

La Universidad de Oxford sostiene que, en el futuro cercano, un 90% de los trabajos existentes serán realizados por inteligencias artificiales. El Nomura Research Institute, además, calcula que el 49% de los trabajos actuales desaparecerá en 15 años (Haque 2020, 207).

A pesar de lo rotundo de estos datos, es necesario entender que cualquier estudio que analice la sustitución de humanos por máquinas en la cadena productiva deberá tener en cuenta muchos otros factores que a menudo, por la conveniencia del impacto mediático que la referencia a los robots ya la inteligencia artificial tiene, son ignorados.

En el corto plazo, no parece que los robots vayan a tener un impacto tan grande como otros factores como la deslocalización o la realidad geopolítica.

En 2018, Elon Musk trató de automatizar por completo la cadena de montaje de vehículos Tesla en su fábrica de Silicon Valley. Tras el intento inicial, fue totalmente incapaz de satisfacer ni siquiera la mitad de la producción que se había establecido como objetivo, y terminó por llamar al intento «infierno fabricante» y decir que «los humanos están infravalorados» en Twitter (Darling 2021, 13).

En otros ámbitos, como el de la educación, los intentos de sustituir a personas por robots tampoco han terminado de convencer a los estudiantes, además de plantear formidables retos que han sido analizados en otro artículo (Álvarez Villanueva 2021).

De todos modos, los imaginarios alimentados por las grandes historias de ficción van, como veremos más abajo, orientados hacia la sustitución de las personas no solo en lo laboral, sino en ámbitos que requieren que las inteligencias artificiales sean capaces de emular por completo a los seres humanos.

Los imaginarios alimentados por las grandes historias de ficción van orientados hacia la sustitución de las personas no solo en lo laboral, sino en ámbitos que requieren que las inteligencias artificiales sean capaces de emular por completo a los seres humanos

Aunque el presente trabajo se centrará en las inteligencias artificiales destinadas al acompañamiento sentimental y a la satisfacción de las necesidades sexuales, conviene mencionar, aún de pasada, el otro gran polo de robots sociales, los dedicados a la asistencia de personas con trastornos o necesidades especiales.

En el terreno de los cuidados asistenciales, algunos robots no humanoides como la foca robótica Paro están teniendo una excelente acogida y ofreciendo resultados prometedores en pacientes con demencia y autismo (Šabanovi et al. 2013, Hung et al. 2019, Libin y Libin 2004, 1795).

Sin embargo, numerosas voces han puesto en tela de juicio la necesidad real de que estos robots muestren una genuina inteligencia o sociabilidad para cumplir bien con su trabajo (Fong, Nourbakhsh y Dautenhahn 2003, 160). O incluso si la sustitución de personas por robots es moralmente aceptable en casos de vulnerabilidad, tales como el cuidado de ancianos por el peligro de condenar a estas personas a una suerte de «ostracismo emocional» al dejar de interactuar con otros seres humanos (Laitinen, Niemelä y Pirhonen 2019).

Se ha puesto en tela de juicio la necesidad real de que estos robots sociales muestren una genuina inteligencia o sociabilidad para cumplir bien con su trabajo, e incluso si la sustitución de personas por robots es moralmente aceptable en casos de vulnerabilidad, tales como el cuidado de ancianos por el peligro de condenar a estas personas a una suerte de «ostracismo emocional» al dejar de interactuar con otros seres humanos

Pareto Boada, Román Maestre y Torras Genís (2021) hace una revisión pormenorizada sobre los principales debates éticos en torno a los robots de cuidados asistenciales.

En cualquier caso, este tipo de análisis recibe más atención académica que mediática, y por tanto estos robots están menos presentes en los imaginarios y sufren menos la influencia del aire caliente que los destinados al acompañamiento sentimental y sexual, de modo que nos centraremos en estos últimos.

El imaginario sobre el amor con entidades artificiales se retrotrae, como mínimo, al mito de Pigmalión. En este relato, el escultor del mismo nombre, incapaz de encontrar a la mujer perfecta, decidió crear él mismo varias esculturas femeninas, enamorándose de una de ellas, Galatea, que finalmente fue atraída a la vida por mediación de Afrodita.

En el mito de Pigmalión, el escultor del mismo nombre, incapaz de encontrar a la mujer perfecta, decidió crear él mismo varias esculturas femeninas, enamorándose de una de ellas, Galatea, que finalmente fue atraída a la vida por mediación de Afrodita.

En nuestra época, podemos encontrar numerosos ejemplos de robots con morfología humana y dotados de inteligencia que resultan atractivos para las personas.

En nuestra época, podemos encontrar numerosos ejemplos de robots con morfología humana y dotados de inteligencia que resultan atractivos para las personas.

Por ejemplo, María, la protagonista de la película Metrópolis (Lang 1927) tiene un doble robótico que comparte el atractivo de aquella, y que incluso llega a actuar como una bailarina exótica. En la película AI (Spielberg 2001) Gigolo Joe es un robot que está programado para emular el romance y tener sexo. Otros ejemplos similares pueden ser encontrados en las series Westworld (Nolan 2016) o Humans (Arnold y otros, 2015) o en la película Her (Jonce 2013), entre muchas otras.

Jennifer Rhee hace un interesante análisis de la novela ¿Sueñan los androides con ovejas eléctricas? (Dick 1968), obra que inspiró la película Blade Runner (Scott 1982) a pesar de las grandes diferencias entre ambas, y de su precuela Podemos construirte (Dick 1972).

Según Rhee, lo que distingue a las entidades artificiales de las personas es la capacidad de sentir emociones, aunque durante el desarrollo de las novelas la trama llevará a la conclusión de que los no humanos muestran comportamientos más empáticos hacia las personas que al contrario (Rhee 2018, 118).

Lo que distingue a las entidades artificiales de las personas es la capacidad de sentir emociones, aunque el desarrollo de la trama llevará a la conclusión de que los no humanos muestran comportamientos más empáticos hacia las personas que al contrario

Esto tiene su reflejo en el imaginario sobre los robots, ya que lo que hace especiales a todos los robots que aparecen en la ciencia ficción como amigos o amantes de las personas es su capacidad de sentir y relacionarse, en oposición de otras máquinas como los frigoríficos o los lavavajillas, que no muestran ningún rasgo emocional.

Lo que hace especiales a todos los robots que aparecen en la ciencia ficción como amigos o amantes de las personas es su capacidad de sentir y relacionarse, en oposición de otras máquinas como los frigoríficos o los lavavajillas, que no muestran ningún rasgo emocional

Aunque las personas tiendan todavía a humanizar de algún modo a las máquinas no programadas para tener un comportamiento empático (Jones 2017), tenderán a calificar de «robot» solamente a aquella máquina que imita de algún modo el comportamiento humano -excepto en el caso de que lleven un adjetivo relacional (de cocina, de limpieza...)-, algo que sin embargo no está presente en absoluto en la definición que da la Organización Internacional de Standarización (ISO), que solo se basa en su operatividad y autonomía para realizar diferentes tareas sin supervisión (Devlin 2020, 44).

Aunque las personas tiendan todavía a humanizar de algún modo a las máquinas no programadas para tener un comportamiento empático, tenderán a calificar de «robot» solamente a aquella máquina que imita de algún modo el comportamiento humano -excepto en el caso de que lleven un adjetivo relacional (de cocina, de limpieza...).

Algo que sin embargo no está presente en absoluto en la definición que da la Organización Internacional de Standarización (ISO), que solo se basa en su operatividad y autonomía para realizar diferentes tareas sin supervisión.

Respecto a la sustitución de las personas por robots fuera de la ficción, existe también una abundante literatura cuyo pionero fue David Levy con su obra Amor y sexo con robots (2008).

Levy hace un análisis concienzudo sobre cómo y de quién nos enamoramos las personas, y por qué, debido a la flexibilidad en la personalidad y características físicas que los robots pueden tener, estos pueden ser mejores amantes y más atractivos para nosotros y nosotras que otros seres humanos. Levy incluso se plantea la cuestión de si podrá ser creíble la reciprocidad sentimental de los robots hacia las personas.

Levy incluso se plantea la cuestión de si podrá ser creíble la reciprocidad sentimental de los robots hacia las personas

Apoyándose en las investigaciones de Reeves y Nass (2002), que demostraron ron que las personas interactuamos con ordenadores y otras máquinas dotándoles de cierta entidad emocional y dignidad a pesar de ser plenamente conscientes de que no sienten emoción alguna, Levy concluye que

«si parece que le gustas a un robot, si se comporta en todas las formas como si le gustaras, entonces puedes asumir con seguridad que realmente te gusta, en parte porque no hay evidencia en sentido contrario» (Levy 2008, 147).

La misma línea de argumentación siguen Meacham y Studley, que sostienen que frente a la perspectiva inferencialista analógica, que consistiría en aceptar que importamos al sujeto con el que interactuamos siempre y cuando sea capaz de experimentar emociones realmente, se puede aceptar una perspectiva enactivista, que enfatiza los patrones de interacción, ya que realmente todas las personas actúan con los otros calculando en sus gestos y comportamientos y no en representaciones internas ajenas a las que no les es posible acceder (Meacham y Studley 2017, 103).

Algunos estudios apuntan a que, en el caso del sexo, la conducta de los participantes en el acto es uno de los principales factores a la hora de alentar el deseo en las personas, llegando al punto en el que las personas que tienen encuentros sexuales con robots ponen en suspenso entonces la incredulidad que sería esperable en estos casos siempre que los códigos sexuales establecidos por la cultura se cumplan y los participantes se sientan seguros y cómodos (Szczuka, Hartmann y Krämer 2019).

En sentido contrario, hay una gran bibliografía académica que sostiene que, incluso si los robots sexuales (sexbots) son capaces de satisfacer los gustos y necesidades relativas al sexo de algunas personas, probablemente la idea de robots que sustituyen a las personas en relaciones afectivas más amplias es una labor mucho más difícil.

Por ejemplo, John Sullins (2012, 408) observa que el amor es más que tener un comportamiento específico y que incluye una dimensión ética de autorrealización, compasión y enriquecimiento mutuo, y concluye que un robot difícilmente podría contribuir a tales metas.

El amor es más que tener un comportamiento específico y que incluye una dimensión ética de autorrealización, compasión y enriquecimiento mutuo, y concluye que un robot difícilmente podría contribuir a tales metas

Mark Coeckelberg (2010, 7) comparte esta visión, sosteniendo que, aunque no es totalmente necesario que el robot sienta empatía para ser amado por una persona, esto sí es importante cuando es capaz de compartir sentimientos de vulnerabilidad que contribuyen a que su acompañante humano pueda ver reflejados este tipo de sentimientos y se sienta comprendido.

Por otro lado, Nishio, Taura e Ishiguro (2012) han encontrado que es posible para los robots, usando expresiones faciales, afectar los sentimientos de las personas con las que interactúan, aunque admitan que la investigación esté en un episodio temprano.

A pesar de que los robots sexuales actuales, como Roxxxy, Solana o Harmony, no tienen realmente una capacidad de expresión emocional realistas, existen comunidades de usuarios de muñecas sexuales y androides en varios países, como Davecat, un hombre de Detroit que comparte su vida con sus muñecas Elena y Sidore, considerando a esta última su mujer y afirmando que ha desarrollado vínculos emocionales con ella análogos a los que desarrollaría con una mujer humana (Danaher 2018, 9).

Nyholm y Frank (2018, 234) opinan que, si un robot está programado para amar a una persona y no tiene una elección real, no es posible tener la misma experiencia que se tendría con un amante que tenga posibilidad real de elegir. Por tanto, sería deseable, como se puede ver en la ficción, que los los robots tuvieran esa capacidad.

Los autores dejan abierta la posibilidad de construcción de una máquina con estas características, pero avisan que la dificultad de fabricar un robot así sería inmensa, y que quizás no mereciera la pena embarcarse en tal proyecto.

A pesar de lo expuesto, las personas siguen estableciendo relaciones serias y contrayendo matrimonio con muñecas sintéticas (Bates 2013) y, aunque este fenómeno todavía sea de nicho, algunos expertos han demostrado que factores como la soledad, que normalmente se toman como condicionantes para que una persona opte por una compañía no humana, no juegan un papel determinante en la elección de seres sintéticos sobre personas para desarrollar relaciones afectivas (Szczuka y Krämer 2017).

Algunos expertos han demostrado que factores como la soledad, que normalmente se toman como condicionantes para que una persona opte por una compañía no humana, no juegan un papel determinante en la elección de seres sintéticos sobre personas para desarrollar relaciones afectivas

La idea de que los robots tengan una conciencia y una capacidad de elección real, además de capacidad emocional genuina, es la versión que más ha permeado en el imaginario sobre los robots de acompañamiento gracias a las historias de ficción que, como se ha expuesto más arriba, los presentan como personas artificiales que sustituyen a las de carne y hueso.

Hay más personas que dirían que si una persona en una relación sentimental con otra persona tuviera relaciones sexuales con un robot estaría cometiendo una infidelidad (42%) que personas que no lo verían así (32%)

Es interesante observar que, según una encuesta realizada en 2013 a 1000 adultos, hay más personas que dirían que si una persona en una relación sentimental con otra persona tuviera relaciones sexuales con un robot estaría cometiendo una infidelidad (42%) que personas que no lo verían así (32%) (McArthur 2017, 31).

Según la versión prevalente en el imaginario sobre los robots de acompañamiento, pues, los robots son vistos como personas sintéticas. Para tal fin, parece claro que necesitan poseer capacidad emocional e inteligencia, lo cual abre una batería de problemas que serán analizados a continuación.

Según la versión prevalente en el imaginario sobre los robots de acompañamiento, los robots son vistos como personas sintéticas. Para tal fin, necesitan poseer capacidad emocional e inteligencia.

4. Emociones, Moralidad y Derechos

Definir qué son las emociones para poder implementarlas en una IA es una tarea plagada de dificultades.

La primera de estas dificultades es que no hay, ni remotamente, un consenso sobre qué son las emociones. De hecho, hay tantas teorías diferentes que numerosos académicos las clasifican en varios grupos según qué parámetros son los principales para cada teoría (Scarantino 2018, Sánchez-Escribano 2018, Strongman 2006, Pineda Oliva 2019).

En este momento, por tanto, los robots desarrollados dentro del campo de la computación afectiva están programados con estructuras emocionales que emulan el comportamiento emocional con mayor o menor complejidad, seleccionando la teoría de las emociones que mejor se adapte a la tarea de programación.

En este momento, los robots desarrollados dentro del campo de la computación afectiva están programados con estructuras emocionales que emulan el comportamiento emocional con mayor o menor complejidad, seleccionando la teoría de las emociones que mejor se adapte a la tarea de programación

Las teorías OCC de Ortony, Clore y Collins (1988) en conjunción con la teoría de las emociones básicas de Ekman (Ekman, Friesen y Ellsworth 1972) son las más populares, pero estas teorías no están en absoluto exentas de críticas (Hudlika 2014, 8, Feldman Barret 2018, 78).

Si, como sostiene Scarantino (2018), hay un amplio consenso entre la comunidad científica de que las emociones tienen una base cognitiva, y que la conceptualización y reflexión humanas y la emoción están ligadas (Damasio 1994, 145), se sigue que la capacidad para dotar de conciencia e inteligencia a las máquinas es una tarea mucho más compleja de lo anticipado.

La cuestión de que las máquinas no vayan a estar dotadas de inteligencia y emocionalidad genuina enfría otro de los temores más latentes sobre la IA: el hecho de que quieran tomar el control y dominarnos. Al menos, conscientemente.

La cuestión de que las máquinas no vayan a estar dotadas de inteligencia y emocionalidad genuina enfría otro de los temores más latentes sobre la IA: el hecho de que quieran tomar el control y dominarnos

Nick Bostrom (2017) y Max Tegmark (2017, 43) han apuntado que todavía existiría la posibilidad de que una IA destruya el mundo o a la humanidad si le son asignados los medios equivocados. Una máquina que tendría como fin hacer el máximo de sujetapapeles posibles tendería a optimizar la producción de estos, fabricando todos los que le fuera físicamente posible utilizando todos los medios a su alcance. Literalmente.

De todas formas, parece más asequible programar una máquina para que tenga ciertas limitaciones en su operatividad que dotarla de inteligencia real que le permitiría desear activamente la destrucción de la humanidad o empresas similares.

Parece más asequible programar una máquina para que tenga ciertas limitaciones en su operatividad que dotarla de inteligencia real que le permitiría desear activamente la destrucción de la humanidad o empresas similares

Algunas personalidades del mundo de la IA, como Oren Etzioni, CEO del Allen Institute for AI, o Bill Gates, afirma que se preocupa de este tipo de amenazas no tiene mucho sentido (Russell 2019, 152).

Otra cuestión es importante a la hora de pensar sobre la IA: los imaginarios sociotécnicos, como sostiene Jassanof, están embebidos en las culturas políticas de las diferentes naciones (Jassanof y Kim 2015b, 335).

Los imaginarios sociotécnicos están embebidos en las culturas políticas de las diferentes naciones, siendo estas instituciones las que articulan su valor normativo y ayudan a apuntalar los socialmente

Al mismo tiempo, son «estabilizados por las instituciones» (Jassanof y Simmet 2021, 4), siendo estas instituciones las que articulan su valor normativo y ayudan a apuntalar los socialmente.

Veremos brevemente a continuación algunos ejemplos sobre cómo las diferentes naciones toman partido social e institucional en el asunto de los robots que se presentan como sustitutos de las personas.

Como se ha comentado anteriormente, las obras de ciencia ficción de la cultura occidental retratan a menudo estas tecnologías como amenazas existentes. Por otro lado, la sociedad japonesa, por ejemplo, tiene más facilidades. papá para ver a los robots como compañeros y amigos, quizás mediada por la religión sintoísta, que considera una multiplicidad de entidades no humanas poseer un espíritu (kami) (Turner 2019, 50, Klærke-Olesen et al, 2018).

Así, Japón es líder en patentes para la creación de robots asistenciales (Meacham y Studley 2017, 101). Además, las costumbres sociales japonesas y la mayor. aceptación de robots e inteligencias artificiales y entidades virtuales en generación crea una situación propicia para la asimilación de estas (Corner 2018, Appel, Marker y Mara, 2019).

China, por su parte, sigue este precepto introduciendo profusamente robots y tecnologías de IA con la intención de convertirse en líder de la tecnología e ignorando por lo general los grandes temores del imaginario occidental (van Noort 2022), a pesar de que en su imaginario tradicional sí existen ciertos prejuicios contra las máquinas como corruptoras del espíritu de las personas (Kroes y Verbeek 2014, 2).

En términos de robots de acompañamiento, China tiene cada vez una mayor apertura, debido en parte a los problemas demográficos que enfrenta, habiendo mucha mayor abundancia de hombres que de mujeres. Así, el negocio de los sexbots, que no solo son usados para el sexo, sino para perseguir un vínculo emocional significativo, sigue en aumento (Fong 2017).

Por el momento, debido a lo incipiente de la tecnología, no hay estrategias nacionales para regular la producción y consumo de sexdolls o robots de acompañamiento, excepto en algunos estados de Estados Unidos (Forbes 2020).

También pueden incluirse aquí una serie de condenas en que tuvieron lugar en 2017 en Reino Unido por la importación de robots sexuales que imitaban la anatomía infantil, basada en una ley generalista y muy antigua de «importación de objetos obscenos» (Devlin 2018, 246).

Algunos grupos, como el CASR (Campaing Against Sex Robots) llevan tratando de paralizar la producción de robots sexuales desde 2015, logrando algunos éxitos parciales, como cuando influyeron en oficiales del gobierno malasio para cancelar la Conferencia Internacional sobre el Amor y Sexo con Robots, organizada por David Levy, aunque en Occidente sus éxitos han sido más bien modestos (Danaher, Earp y Sandberg 2018, 47).

5. Personas Robóticas y su Entidad Moral

Uno de los casos más paradigmáticos de decisión moral que podrían enfrentar las máquinas -por ejemplo, los coches con conducción automática que se enfrentarán a un accidente inevitable- es el que Philippa Foot diseñó en 1967 sobre el tranvía que se dirige inexorablemente al atropello de cinco personas, excepto si un sujeto que tiene la capacidad de intervenir opta por mover una manivela que acciona un cambio de vía que posibilitaría que el tranvía atropellase solo a una que está en una vía paralela (Foot 1967, 2).

Si introducimos algunas variantes del mismo experimento, como la posibilidad de detener el tren que se dispone a atropellar a un grupo de personas empujando a una persona corpulenta para que caiga a la vía y se sacrifique bloqueando el paso del tren, tenemos algunas variedades en los resultados.

Si contemplamos la decisión racional como la válida moralmente concluiremos que solo los robots pueden ser éticos ya que solo ellos pueden ser puramente racionales

Si contemplamos la decisión racional como la válida moralmente, concluiremos, siguiendo la opinión de Joseph Emile Nadeau, que solo los robots pueden ser éticos ya que solo ellos pueden ser puramente racionales (Nadeau apud Gunkel 2017, 64).

las emociones […] cuentos como el miedo, la tristeza y la ira pueden funcionar como marcadores universales de posibles daños morales para todos los miembros de la especie humana, más allá de las diferencias culturales, como alarmas que advierten de un posible daño. (Cabezas 2014, 265)

Como hemos visto antes con las reacciones en encuestas sobre el caso del tranvía, no todas las personas decidirían intervenir para salvar a unos y condenar a otros

La percepción de la agencia moral, como hemos visto, también puede estar sujeta a variaciones según la cultura

No es disparatado pensar que algunas culturas que no establecieron un corte tan grande entre lo humano y lo no humano, como la japonesa, puedan asignar un grado diferente de agencia a los robots

Es interesante notar que estos castigos y recompensas solo tienen sentido cuando el receptor es capaz de sentir placer o disgusto, y también que cualquier recompensa dada por las personas tiene como referencia el interés de estos

Cualquier sistema ético que se implemente hacia los robots tendrá en cuenta primeramente las consideraciones morales de las personas; por tanto, será para ellos una moral heterónoma.Si los robots son inteligentes o sienten emociones genuinas, sería justo que ellos tuvieran una participación en la configuración de sus propios sistemas morales.

Principios morales en las máquinas que sean diferentes a los humanos probablemente no serían bien recibidos por nosotros

«Creo que una máquina puede ser definitivamente una persona. […]. No serán humanos porque están hechos de diferente material, pero serán parte de nuestra comunidad, no hay ninguna duda en mi mente» (sobre esto, Foerst apud Gunkel 2017, 172).

El debate de si los robots podrán ser considerados personas legales pone de relieve un claro sesgo, toda vez que existen animales no humanos a nuestro alrededor que poseen una inteligencia y una capacidad emocional genuina

Es comprensible, de todos los modos, que haya una mayor tendencia a personificar a los robots debido al citado aire caliente que los investigadores de campo promueven y que supone un importante acicate para los imaginarios socio-técnicos sobre la IA.

Los robots sociales, que son los que más probablemente veamos como personas, son producidos para realizar funciones para nosotros los humanos en un régimen de esclavitud funcional

6. Conclusión: «Aire Caliente» y Expectativas

Parece claro que, pese a que la capacidad computacional aumenta exponencialmente en los próximos años, y a a pesar del criterio de algunos especialistas (Kurzweil 2006), la capacidad emocional y la verdadera inteligencia para las máquinas necesarias para la aclaración conceptual y operativa de ambas categorías o la capacidad de hacer un modelo funcional del cerebro y probablemente de algunas otras áreas del cuerpo.

Mientras tanto, no obstante, el aire caliente producido por las historias de ciencia ficción y las constantes evoluciones técnicas anunciadas con titulares capciosos en prensa siguen haciendo pensar al público que estas capacidades son ya una realidad o están cerca de serlo.

Los imaginarios sobre las IA de acompañamiento han sido impulsados por las obras académicas, como el trabajo de Levy atestigua, pero también por la ciencia ficción, algunos expertos del campo y los titulares de prensa cargados de aire caliente que animan a creer que las personas sintéticas podrían ser una realidad. Estos imaginarios, como explica Jasanoff, a su vez coproducen e impulsan la tecnología creada, mostrando robots cada vez más capaces de imitar los comportamientos humanos.

Estos imaginarios, a su vez coproducen e impulsan la tecnología creada, mostrando robots cada vez más capaces de imitar los comportamientos humanos

Es posible delimitar con argumentos los límites del aire caliente en cámara como la conveniencia de la asignación de derechos de las máquinas o la capacidad de dotarlas de capacidades emocionales; lo que no es posible es limitar de este modo las expectativas, emociones y sueños de las personas que interactúan diariamente con inteligencias artificiales de una forma u otra.

Es importante reflexionar sobre el hecho de que las leyes las hacen las personas que el público vota, y que si dejamos que la sociedad se deje llevar por sensaciones alarmistas quizás acabemos enfrentándonos a los debates equivocados que terminan en leyes exageradas o injustas mientras ignoramos otros, como el verdadero trabajo en la sombra de millones de personas que trabajan, y su inmensa precariedad, para que grandes compañías puedan presumir de los flamantes resultados de sus sistemas de IA (Crawford 2021).

Por tanto, es importante aprender a convivir con el aire caliente que haga subir el globo del bombo publicitario más y más hacia las alturas, pero quizás sea conveniente también viajar en este globo con una brújula y un mapa, para al menos tener una idea, aunque sea vaga, de a dónde nos dirigimos.

Es importante aprender a convivir con el aire caliente que haga subir el globo del bombo publicitario más y más hacia las alturas, pero quizás sea conveniente también viajar en este globo con una brújula y un mapa, para al menos tener una idea, aunque sea vaga, de a dónde nos dirigimos

***

7. Referencias Bibliográficas

Álvarez Villanueva, Enrique. «Pensar (en) el futuro: Cuestiones sobre la enseñanza de la Filosofía y la Inteligencia Artificial», Paideia 116 (2021): 59-70.

Appel, Markus, Caroline Marker y Martina Mara. «Otakuism and the appeal of sex robots», Frontiers in Psychology 10 (2019).

Arnold, Sam, et al. directores. 2015. Humans, Kudos Film and Television.

Bates, Daniel. «Meet Davecat: The 40-year-old man who has rejected ‘organic women’ to marry a synthetic doll and have another as a mistress». Mail Online. 2013.

Bostrom, Nick. Superintelligence. Paths, Dangers, Strategies. Oxford: Oxford University Press, 2014.

Boyon, Nicolas. «Global opinions on AI vary by countries’ level of economic development». Ipsos. 2022.

Breazeal, Cynthia, Atsuo Takanishi y Tetsunori Kobayashi. «Social Robots that Interact with People». En Bruno Siciliano y Oussama Khatib (Ed.), Springer Handbook of Robotics, 1349-1369. Berlín: Springer, 2018.

Buchholz, Katharina. «Americans Fear the AI Apocalypse». Statista. 2019.

Burden, David y Maggi Savin-Baden. Virtual Humans. Today and Tomorrow. Boca Ratón: CRC Press, 2019.

Cabezas, Mar. Ética y emoción. El papel de las emociones en la justificación de nuestros juicios morales. Madrid: Plaza y Janés, 2014.

Coeckelbergh, Mark. «Artificial Companions: Empathy and Vulnerability Mirroring in Human-Robot Relationships». Studies in Ethics, Law and Technology 4 (3) (2010).

Corner, Natalie. «Child-sized sex doll made in Japanese factory reduces TV presenter to tears – as the manufacturer admits customers decide the robots’ ages». Mail Online. 2018.

Crawford, Kate. Atlas of AI. Cornwall: Yale University Press, 2021.

D’Olimpio, Laura. «The trolley dilemma: would you kill one person to save five?». The Conversation, Melbourne. 2016.

Damasio, Antonio. Descartes’ Error. Emotion, Reason and the Human Brain. Nueva York: Avon Books, 1994.

Damasio, Antonio. En busca de Spinoza. Neurobiología de la emoción y los sentimientos. Trad. Joandomènec Ros. Barcelona: Planeta, 2005.

Danaher, John. «Should We Be Thinking About Sex With Robots?», En John Danaher y Neil McArthur (Ed.), Robot Sex. Social and Ethical Implications, 3-14. Cambridge: MIT Press, 2018.

Danaher, John, Brian Earp y Anders Sandberg. «Should We Campaign Against Sex Robots?», En John Danaher y Neil McArthur (Ed.), Robot Sex. Social and Ethical Implications, 47-72. Cambridge: MIT Press, 2018.

Darling, Kate. The New Breed. How to Think About Robots. Londres: Allen Lane, 2021.

Devlin, Kate. Turned On. Science, Sex and Robots. Londres: Bloomsbury, 2018.

Dick, Philip. Do Androids Dream of Electric Sheep?. Auckland: SF Masterworks, 2010.

Dick, Philip. We Can Build You. Nueva York: First Mariner Books, 1972.

Ekman, Paul, Wallace V. Friesen y Phoebe Ellsworth. Emotion in the Human Face: Guidelines for Research and an Integration of Findings. Nueva York: Pergamon Press Inc., 1972.

Forbes. «Piden prohibir la venta de muñecas sexuales con aspecto infantil en EU». Forbes México. 2020.

Fong, Mei. «Sex dolls are replacing China’s missing women». Yahoo Finance. 2017.

Fong, Terrence, Illah Nourbakhsh y Kerstin Dautenhahn. «A Survey of Socially Interactive Robots», Robotics and Autonomous Systems 42 (2003): 143-166.

Foot, Philippa. «The Problem of Abortion and the Doctrine of the Double Effect». Oxford Review 5 (1967): 5-15.

Gunkel, David J. The Machine Question. Critical Perspectives on AI, Robots, and Ethics. Massachusetts: The MIT Press, 2017.

Hanson, F. Allan. «What Came First, the Maker or the Made?». En Peter Kroes y Peter-Paul Verbeek (Ed.), The Moral Status of Technical Artefacts, 55-73. Nueva York: Springer, 2014.

Haque, Emon. The Ultimate Guide to Artificial Intelligence. Londres: Amazon Inc., 2020.

Herreros Ubalde, Pablo. La inteligencia emocional de los animales. Barcelona: Ediciones Destino, 2018.

Hockenhull, Michael y Marisa Leavitt Cohn. «Hot air and corporate sociotechnical imaginaries: Interpreting and translating digital futures in the Japanese tech scene», New Media & Society 23, 2 (2021): 302-321.

Hung, Lillian et al. «The benefits and barriers of using a social robot PARO in care settings: a scoping review». BMC Geriatr 19, 232 (2019): 1-10.

Jasanoff, Sheila. «Future Imperfect: Science, Technology, and the Imaginations of Modernity». En Sheila Jasanoff y Sang-Hyun Kim (Ed.), Dreamscapes of Modernity: Sociotechnical Imaginaries and the Fabrication of Power, 1-33. Chicago: University of Chicago Press, 2015a.

Jasanoff, Sheila. «Imagined and Invented Worlds», en Sheila Jasanoff y Sang-Hyun Kim (Ed.), Dreamscapes of Modernity: Sociotechnical Imaginaries and the Fabrication of Power, 321-341. Chicago: University of Chicago Press, 2015b.

Jasanoff, Sheila y Hilton R. Simmet. «Reimagining the future: Excluded imaginaries in the global energy transition», Energy Research & Social Science 80, artículo 102205 (2021).

Jonze, Spike. director. 2014. Her, Vértigo Films.

Jones, Raya A. «What makes a robot “social”?». Social Studies of Science 47, 4 (2017): 556-57.

Klærke-Olesen, Anne et al. Imagining Life With AI Robots (Tesis de maestría). Universidad de Aalborg, Dinamarca, 2018.

Kroes, Peter y Peter-Paul Verbeek. «Introduction: The Moral Status of Technical Artefacts». En Peter Kroes y Peter-Paul Verbeek (Ed.) The Moral Status of Technical Artefacts, 1-9. Nueva York: Springer, 2014.

Kurzweil, Ray. The Singularity Is Near, Londres: Duckworth Publishers, 2006.

Laitinen, Arto, Marketta Niemelä y Jari Pirhonen. «Demands of Dignity in Robot Care: Recognizing Vulnerability, Agency, and Subjectivity in Robot-Assisted, Robot-Based, and Teleoperated Health Care for Older People». Techné: Research in Philosophy and Technology 23, 3 (2019): 366-401.

Lang, Fritz, director. 1927. Metropolis, UFA.

Larson, Erik. The Myth of Artificial Intelligence: Why Computers Can’t Think the Way We Do, Cambridge: Harvard University Press, 2021.

Levy, David. Love and Sex with Robots, Wiltshire: Cromwell Press Ltd, 2008.

Libin, Alexander y Elena Libin. «Person-Robot Interactions From the Robopsychologists’ Point of View: The Robotic Psychology and Robotherapy Approach». Proceedings of the IEEE 92, 11 (2004): 1789-1803.

Lizana, José Alberto. «Tras charlar con una Inteligencia Artificial, ahora este ingeniero de Google piensa que tienen plena conciencia». Genbeta. 2022.

López de Mantarás Badía, Ramón y Pedro Meseguer González. ¿Qué sabemos de? Inteligencia artificial, Madrid: CSIC, 2017.

McArthur, Neil. «The Case for Sex Robots», en John Danaher y Neil McArthur (Ed.) Robot Sex. Social and Ethical Implications, 31-47. Cambridge: MIT Press, 2018.

McCarthy, John et al. «A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, August 31, 1955». AI Magazine 27, 4 (2006): 12-14.

Meacham, Darian y Matthew Studley. «Could a Robot Care? It’s All in the Movement». En Patrick Lin, Ryan Jenkins y Keith Abney (Ed.). Robot Ethics 2.0. From Autonomous Cars to Artificial Intelligence, 97-112. Nueva York: Oxford University Press, 2017.

Mejía Fernández, Ricardo. Pensar la inteligencia artificial. El legado de Hubert Dreyfus a la fenomenología. Madrid: McGraw-Hill, 2020.

Minsky, Marvin. The Emotion Machine. Commonsense Thinking, Artificial Intelligence, and the Future of the Human Mind. Nueva York: Simon & Schuster Paperbacks, 2006.

Mitcham, Carl. «Agency in Humans and in Artefacts: A Controversial Revealing». En Peter Kroes y Peter-Paul Verbeek (Ed.). The Moral Status of Technical Artefacts, 11-29. Nueva York: Springer, 2014.

Nass, Clifford y Youngme Moon. «Machines and Mindlessness: Social Responses to Computers», Journal of Social Issues 56, 1 (2000): 81-103.

Nishio, Shuichi, Koichi Taura y Hiroshi Ishiguro. «Emotion Regulation using Facial Expression Feedback from Teleoperated Android Robot», En Shuzhi Sam Ge et al (Ed.). Social Robotics, 388-397. Berlín: Springer, 2012.

Nolan, Jonathan, director. 2016. Westworld, Warner Bros.

Nyholm, Sven y Lily Eva Frank. «From Sex Robots to Love Robots: Is Mutual Love with a Robot Possible?». En John Danaher y Neil McArthur (Ed.). Robot Sex. Social and Ethical Implications, 219-244. Cambridge: MIT Press, 2018.

Ortony, Andrew, Gerald Clore y Allan Collins. The Cognitive Structure of Emotions. Nueva York: Cambridge University Press, 1988.

Pareto Boada, Júlia, Begoña Román Maestre y Carme Torrás Genís. «The ethical issues of social assistive robotics: A critical literature review». Technology in Society 67, artículo 101726. (2021).

Picard, Rosalind. Affective Computing. Massachusetts: MIT Press, 2000.

Pineda Oliva, David. Sobre las emociones. Madrid: Cátedra, 2019.

Rahwan, Iyad, Kerstin Skork y Elena Hungerland. «Sacrificing one person to save five?». Max-Planck-Gesellschaft. 2020.

Reeves, Byron y Clifford Nass. The Media Equation. How People Treat Computers, Television and New Media Like Real People and Places. Stanford: CSLI, 2002.

Rhee, Jennifer. The Robotic Imaginary. The Human and the Price of Dehumanized Labor. Minneapolis: University of Minnesota Press, 2018.

Rolls, Edmund T. The Brain, Emotion, and Depression, Nueva York: Oxford University Press, 2018.

Russell, Stuart. Human Compatible. AI and the Problem of Control. Londres: Penguin, 2019.

Russell, Stuart y Peter Norvig. Artificial Intelligence: A Modern Approach. Uttar Pradesh: Pearson, 2019.

Šabanović, Selma, et al. «PARO robot affects diverse interaction modalities in group sensory therapy for older adults with dementia». Proceedings of the IEEE International Conference on Rehabilitation Robotics, artículo 6650427. (2013).

Sánchez-Escribano, María Guadalupe. Computational Engineering of Emotion-A Reference Model for Emotion in Artificial Systems. Nueva York: Springer, 2018.

Scarantino, Andrea. «The Philosophy of Emotions». En Lisa Feldman Barret, Michael Lewis y Jeanette M. Haviland-Jones (Ed.) Handbook of Emotions, 3-48. Nueva York: Guilford Press, 2018.

Scott, Ridley, director. 1982. Blade Runner, Warner Bros.

Searle, John. The Rediscovery of the Mind, Massachusetts: The MIT Press, 2002.

Spielberg, Steven, director. 2001. A.I. Artificial Intelligence, Warner Bros.

Strongman, Kenneth T. The Psychology of Emotion, from Everyday Life to Theory. Norfolk: Wiley, 2006.

Sullins, John. «Robots, Love, and Sex: The Ethics of Building a Love Machine». IEEE Transactions on Affective Computing 3, 4 (2012): 398-409.

Sutherland, Stuart. Irracionalidad: El enemigo interior. Madrid: Alianza, 2015.

Szczuka, Jessica y Nicole Krämer. «Not only the lonely: How men explicitly and implicitly evaluate the attractiveness of sex robots in comparison to the attractiveness of women and personal characteristics influencing this evaluation», Multimodal Technologies and Interaction 1 (1), 3 (2017).

Tegmark, Max. Life 3.0. Being Human in the Age of Artificial Intelligence. Londres: Penguin, 2017.

Turing, Alan. «Computing Machinery and Intelligence». Mind 59, 236 (1950): 433-460.

Turner, Jacob. Robot Rules. Regulating Artificial Intelligence. Londres: Palgrave Macmillan, 2019.

Vallverdú, Jordi et al. «Fake Empathy and Human-Robot Interaction (HRI): a Preliminary Study». International Journal of Technology and Human Interaction 12, 1 (2018): 44-59.

Van Noort, Carolijn. «On the use of pride, hope, and fear in China’s international artificial intelligence narratives on CGTN». AI & Society (2022): 1-13.

*******

RELACIONADOS:

INTELIGENCIA ARTIFICIAL: «Yo, robot», o las tribulaciones de un robot kantiano.

Internet, Robótica, Inteligencia Artificial (IA): documental Completo de WERNER HERZOG

¿Es la conciencia más como el ajedrez o el clima?, por Brian Gallagher

LAS TRES LEYES DE LA ROBÓTICA: «El círculo vicioso» (Runaround,1942), por Isaac Asimov

TRANSHUMANISMO Y POSTHUMANISMO. ¿Inmortales e inhumanos en un futuro distópico?

ROBOTS, AUTOMATIZACIÓN Y TRABAJO ASALARIADO, por Duval («Crónica de clase») – PARTE 1 de 2