MÁQUINAS QUE LEEN LA MENTE

Tabla de contenidos

MÁQUINAS QUE LEEN LA MENTE

Un nuevo sistema de inteligencia artificial puede reconstruir los pensamientos de una persona con gran exactitud a partir del escaneo de su cerebro con fMRI.

Por Laura G de Rivera

Público, 7 MAYO 2023

Metidos cada uno en un escáner de resonancia magnética funcional, tres voluntarios escucharon pacientemente varias historias –en concreto, de un podcast famoso en Estados Unidos–. Mientras, un modelo de lenguaje (LLG, siglas en inglés de Large Language Model), el GPT-1, al que los investigadores se refieren como «descodificador«, iba analizando sus patrones de actividad cerebral en distintas regiones del córtex, buscando correlaciones entre esos datos y el contenido de los mensajes que estaban escuchando. Durante 16 horas –¡no seguidas!– entrenaron al programa para que fuera capaz de traducir la forma en que el cerebro reproducía las historias mientras las escuchaba.

En la siguiente fase del experimento, los voluntarios escuchaban una nueva historia, también dentro del escáner, mientras el decodificador iba generando texto solo a partir de la actividad cerebral registrada por las imágenes neuronales. El éxito fue sorprendente: alrededor del 50% de las veces, el mensaje producido era semánticamente parecido, cuando no idéntico, al original. Lo mismo ocurría cuando, en vez de reproducir un audio, se les ponía un vídeo corto en silencio. El programa era capaz de crear sinopsis de su contenido, solo a partir del escáner cerebral.

¿Funcionaría también para adivinar el pensamiento del voluntario, sin que este escuchara nada? Los investigadores comprobaron que sí. En la siguiente prueba, se les pedía a los participantes que imaginaran una idea o un mensaje bajo el escaneo del fMRI. Y el decodificador fue, de nuevo, capaz de transcribir la actividad cerebral a palabras con bastante precisión en cuanto al contenido semántico.

*******

INTELIGENCIA ARTIFICIAL: EL GPT LOGRÓ LEER EL PENSAMIENTO DE LAS PERSONAS Y TRADUCIRLO EN PALABRAS

Investigadores de la Universidad de Texas utilizaron un resonador magnético para convertir las gráficas de un escáner cerebral en textos y frases similares a los que el paciente estaba escuchando, a través del sistema de AI

Utilizando un programa basado en Inteligencia Artificial (IA) y particularmente el programa GPT-1, una computadora logró decodificar y describir la esencia de las historias que escuchó él y los tres participantes iniciales en el experimento de prueba de concepto, simplemente mirando sus resonancias magnéticas funcionales. Según sus resultados, publicados en la revista científica Nature Neuroscience, este descodificador que han llamado “semántico” fue capaz también de verbalizar lo que pensaban y observaban mientras veían cine mudo.

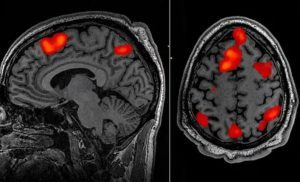

Escuchar esas líneas estimuló la actividad cerebral, las neuronas se dispararon y consumieron el oxígeno en su sangre. A medida que la sangre desoxigenada fluía de regreso a sus pulmones y corazón, el imán captó su señal, decodificando qué partes de su cerebro estaban procesando lo que había escuchado. Los investigadores han desarrollado el primer método no invasivo para determinar la esencia del habla imaginada, presentando una posible salida de comunicación para las personas que no pueden hablar.

Los expertos utilizaron el programa GPT-1. Este modelo de lenguaje, desarrollado por el laboratorio de inteligencia artificial OpenAI, usa aprendizaje profundo para generar texto. En esta investigación, lo entrenaron con las imágenes fMRI del cerebro de tres personas a las que hicieron oír 16 horas de audios de un podcast del New York Times y del programa The Moth Radio Hour, logrando hacer corresponder lo que veían con su representación en la cabeza. La idea es que, cuando volvieran a oír otro texto, el sistema pudiera ir anticipándolo basándose en los patrones de lo ya aprendido.

“Nos sorprendió un poco que funcione tan bien como lo hace. He estado trabajando en esto durante 15 años así que fue impactante y emocionante cuando finalmente funcionó”, explicó Huth, el neurocientífico que dirigió el trabajo en la Universidad de Texas, en Austin. “Se trata del GPT original, no como el nuevo [ChatGPT se apoya en la última versión de GPT, la 4]. Recopilamos una tonelada de datos y luego construimos este modelo, que predice las respuestas cerebrales a las historias”, agregó.

El decodificador podría reconstruir el habla con una precisión asombrosa mientras las personas escuchaban una historia, o incluso imaginaban una en silencio, utilizando solo datos de escaneo fMRI. Los sistemas de decodificación de idiomas anteriores requerían implantes quirúrgicos colocar una serie de electrodos directamente en el cerebro. Pero este último avance plantea la posibilidad de nuevas formas de restaurar el habla en pacientes que luchan por comunicarse debido a un accidente cerebrovascular o una enfermedad de la neurona motora.

Una nueva era

La llegada de grandes modelos de lenguaje, del tipo de IA que sustenta ChatGPT de OpenAI, proporcionó una nueva forma de “hacer hablar a las personas que no pueden hacerlo”. Estos modelos pueden representar, en números, el significado semántico del habla, lo que permite a los científicos observar qué patrones de actividad neuronal correspondía a cadenas de palabras con un significado particular en lugar de intentar leer la actividad palabra por palabra.

Este descodificador recibió el nombre de semántico. Anteriores interfaces registraban la actividad cerebral en las áreas motoras que controlan la base mecánica del habla, es decir, los movimientos de boca, laringe o lengua. “Lo que pueden descodificar es cómo la persona está tratando de mover la boca para decir algo. Nuestro sistema funciona en un nivel muy diferente. En lugar de fijarnos en el ámbito motor de bajo nivel, trabaja en el nivel de las ideas, de la semántica, del significado.Por eso no registra las palabras exactas que alguien escuchó o pronunció, sino su sentido”, explicó Huth. Para esto, aunque las resonancias registraban la actividad de varias zonas cerebrales, se centraron más en las relacionadas con la audición y el lenguaje. La continuación de las pruebas prosiguió en una docena de pacientes, siempre con buenos resultados.

El proceso de aprendizaje fue intensivo: se requirió al principio quetres voluntarios permanecieran acostados en un escáner durante 16 horas cada uno, escuchando podcasts. El decodificador fue entrenado para hacer coincidir la actividad cerebral con el significado utilizando un modelo de lenguaje grande, GPT-1, un precursor de ChatGPT. Más tarde, los mismos participantes fueron escaneados escuchando una nueva historia o imaginando contar una historia y el decodificador se usó para generar texto solo a partir de la actividad cerebral. Aproximadamente la mitad de las veces, el texto coincidía estrechamente, y a veces con precisión, con los significados previstos de las palabras originales.

El decodificador que creó Huth nunca pregunta directamente en qué estaba pensando una persona. En su lugar, utiliza un modelo de “codificación” en un bucle para crear el efecto de “descodificación”. Los investigadores utilizaron GPT-1 para generar posibles conjeturas sobre qué frases escuchó la persona. Luego, utilizando el modelo de “reenvío” o “codificación” que predice la actividad cerebral en función de una frase, modelaron la actividad cerebral que esa frase podría evocar. Al comparar el escaneo predicho con el escaneo real, clasificaron las frases adivinadas de mejor a peor, agregando más palabras a la frase.

“Nuestro sistema funciona a nivel de ideas, semántica, significado”, dijo Huth. “Esta es la razón por la que lo que sacamos no son las palabras exactas, es la esencia”. Por ejemplo, cuando a un participante se le reprodujeron las palabras: “‘No sabía si gritar, llorar o salir corriendo. En lugar de eso, dijo: ¡Déjame en paz!’” se decodificaron como “‘Empecé a gritar y llorar, y luego ella (la máquina) simplemente dijo: ‘Te dije que me dejaras en paz’”. También se les pidió a los participantes que miraran cuatro videos cortos y silenciosos mientras estaban en el escáner, y el decodificador pudo usar su actividad cerebral para describir con precisión parte del contenido.

“Para un método no invasivo, este es un verdadero avance en comparación con lo que se ha hecho antes, que generalmente son palabras sueltas o oraciones cortas”, dijo Huth. A veces, el decodificador se equivocaba y tenía problemas con ciertos aspectos del lenguaje, incluidos los pronombres. “No sabe si es en primera o tercera persona, hombre o mujer”, dijo Huth.

El profesor Tim Behrens, un neurocientífico computacional de la Universidad de Oxford que no participó en el trabajo, lo describió como “técnicamente extremadamente impresionante” y dijo que abrió una gran cantidad de posibilidades experimentales, incluida la lectura de pensamientos de alguien que sueña o investiga cómo nuevas ideas. surgen de la actividad cerebral de fondo. “Estos modelos generativos te permiten ver lo que hay en el cerebro a un nuevo nivel. Significa que realmente puedes leer algo profundo de la fMRI”, agregó.

“Esto es realmente genial, ya que las aportaciones de GPT contienen la semántica del habla, no las propiedades articulatorias o acústicas, como se hacía en anteriores programas como ICB. Muestran que el modelo entrenado en lo que se oye puede descodificar la semántica de películas mudas y también del habla imaginada”. Este científico está “absolutamente convencido de que la información semántica se utilizará en las interfaces cerebro máquina para hablar en el futuro”, indicó el neurocientífico Christian Herff lidera la investigación en interfaces cerebro máquina en la Universidad de Maastricht (Países Bajos) que no participó del experimento.

Anticipándose a estos temores, los autores de los experimentos quisieron comprobar si podían usar su sistema para leer la mente de otros sujetos. Por fortuna, comprobaron que el modelo entrenado con una persona no acertaba a descifrar lo que oía o veía otra. Para asegurarse, realizaron una última serie de ensayos. Esta vez pidieron a los participantes que contaran de siete en siete, pensaran y nombraran animales o se inventaran una historia en su cabeza mientras oían los relatos. Aquí, la interfaz apoyada en GPT, con toda la tecnología que lleva una máquina de resonancia magnética y todos los datos manejados por la IA, falló progresivamente.

Hay dos componentes clave que hicieron posible el nuevo decodificador cerebral: el tesoro de datos recopilados sobre unos pocos participantes, en lugar de las pocas horas habituales de datos sobre muchos participantes, y el advenimiento de los modelos de lenguaje.

*******

HUMANE, EL DISPOSITIVO CON IA QUE PROYECTA IMÁGENES EN LA MANO, QUIERE ACABAR CON LOS MÓVILES PARA SIEMPRE

Dicen que a los móviles les quedan pocos años de vida. Y aquí tenemos la primera prueba.

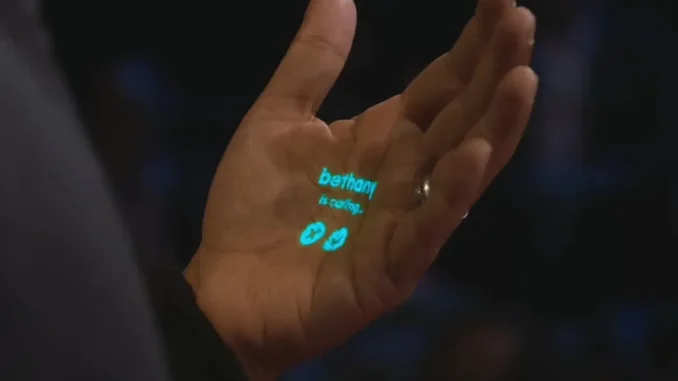

Dos ex-empleados de Apple han presentado un dispositivo con inteligencia artificial que proyecta imágenes en las manos, y quiere terminar con el uso del móvil para siempre.

Es una idea de Imran Chaudhri y Bethany Bongiorno, que tras trabajar en Apple decidieron crear su propia compañía, Humane. ¿Puede, de verdad, jubilar al móvil?

Se dice que los relojes inteligentes o las gafas de realidad mixta pueden hacer que nos olvidemos de los smartphones, pero sus propuestas, por ahora, no terminan de convencer.

Humane (nombre no definitivo) es el primer dispositivo que vemos, que realmente tiene los cimientos para jubilar al móvil. Se trata de una especie de clip que se engancha en la ropa, y está dotado de inteligencia artificial tipo ChatGPT. Es capaz de proyectar una pantalla en la mano o en una pared o mesa, así que ya no necesitamos una pantalla física. Puedes verlo en este vídeo:

La imagen muestra algunos botones, y aunque Imran Chaudhri no los usa, parece que podremos interactuar con esta pantalla proyectada.

Humane no se conecta a ningún móvil o reloj, es un dispositivo independiente. No está claro dónde almacena la información, parece que estará conectado a la nube.

La clave del dispositivo es la inteligencia artificial tipo ChatGPT que integra. Se comunica con la voz, y podemos pedirle cosas como que nos haga un resumen de la reunión a la que hemos asistido, o que busque todo tipo de información.

Puesto que se trata de una IA (no han dicho cuál es), se puede mantener conversaciones con ella mientras caminas por la calle o vas en el coche.

El gadget de Humane también puede traducir conversaciones en tiempo real. Aquí podemos verlo traduciendo del inglés al francés imitando tu propia voz:

Muy útil cuando viajas al extranjero o asistes a una convención, o a una reunión de trabajo internacional.

También posee una cámara, así que puede ver e identificar objetos. En este otro vídeo, identifica una chocolatina y explica las calorías que tiene, y si puede entrar o no en la dieta que estás siguiendo:

Humane se ha desvelado hoy durante una charla en TED, tal como recoge el medio que publica la exclusiva, Inverse. Pero tendremos que esperar a la presentación oficial para conocer todas sus características.

Lo mostrado es un intento bastante coherente de sustituir al móvil: «Nos gusta decir que la experiencia es sin pantalla, sin fisuras, y sensorial, lo que le permite acceder a la potencia de cálculo sin dejar de estar presente en su entorno. La solución de un equilibrio que se ha sentido fuera de lugar desde hace algún tiempo«, explica Imran Chaudhri.

El uso de la inteligencia artificial como ChatGPT, puede eliminar el 80% de los accesos al móvil, porque tiene capacidad para decirnos, con la voz, cualquier dato que necesitemos. O leernos los mensajes.

Para el resto, basta con proyectar la pantalla en la mano, o en la mesa, y ver vídeos o fotos, o interactuar con ella.

El dispositivo con IA de Humane que quiere jubilar el smartphone, nos ha mostrado ideas muy interesantes. Tenemos ganas de conocer todos los detalles en su presentación oficial, que aún no tiene fecha.

*******

RELACIONADOS:

INTELIGENCIA ARTIFICIAL: «Yo, robot», o las tribulaciones de un robot kantiano.

LAS TRES LEYES DE LA ROBÓTICA: «El círculo vicioso» (Runaround,1942), por Isaac Asimov

ROBOTS, AUTOMATIZACIÓN Y TRABAJO ASALARIADO, por Duval («Crónica de clase») – PARTE 1 de 2

Internet, Robótica, Inteligencia Artificial (IA): documental Completo de WERNER HERZOG

Deja tu opinión