INTELIGENCIA ARTIFICIAL

Tabla de contenidos

Secretos sucios de la inteligencia artificial

Los sistemas de inteligencia artificial se expanden y abarcan cada vez más aspectos de nuestra vida cotidiana y de los procesos de producción industrial y otros, como educación y gestión de la salud. Todo ello controlado por unas pocas empresas tecnológicas gigantes, sector de las que provienen los hombres más ricos del mundo. Fortuna que en gran porcentaje se debe a la extracción gratuita y no regulada de datos de las personas y de sus interacciones.

La llamada

inteligenciaartificial, como chatGPT y similares, no son más que sistemas de razonamiento basados en estadísticas pasadas, que carecen de la posibilidad de imaginar realidades diferentes y, por tanto, afirman y promueven el statu quoPor Silvia Ribeiro*

La Jornada, 8 ABRIL 2023

Los sistemas de inteligencia artificial se expanden y abarcan cada vez más aspectos de nuestra vida cotidiana y de los procesos de producción industrial y otros, como educación y gestión de la salud. Todo ello controlado por unas pocas empresas tecnológicas gigantes, sector de las que provienen los hombres más ricos del mundo. Fortuna que en gran porcentaje se debe a la extracción gratuita y no regulada de datos de las personas y de sus interacciones.

Estamos en contacto diario con la inteligencia artificial, aunque no pensemos en ello, por ejemplo a través de los teléfonos móviles que responden a nuestras preguntas, con el uso de motores de búsqueda electrónica y las muchas otras formas de entregar nuestros datos y preferencias en formularios y tarjetas electrónicas de todo tipo (exigidos por ley por instituciones públicas y privadas, por tarjetas bancarias o de asiduidad de comercios, clubes, etcétera). Datos que no quedan aislados por actividad o empresa, sino que se integran en sistemas informáticos que se pueden conectar entre sí. La mayoría de los datos van a parar a muy pocas nubes informáticas gigantes. Casi la totalidad de los datos electrónicos comerciales, personales y gubernamentales están almacenados en las nubes informáticas de Microsoft, Amazon, Google y pocas más.

La recolección de nuestros datos no es un efecto secundario, sino un propósito de estas empresas, ya que su interpretación por sectores de población (etarios, de género, geográficos y de poder adquisitivo, entre otros), por intereses, posiciones políticas y un largo etcétera, es lo que las tecnológicas venden a otras compañías para mercadeo o manipulación de nuestras decisiones. El almacenamiento de esta cantidad inmensa de datos es imposible sin las gigantescas nubes de computación de las empresas, y a su vez, solamente sistemas automatizados de inteligencia artificial pueden interpretarlos.

Pero cada uno de esos sistemas de [supuesta] inteligencia son a su vez entrenados y alimentados manualmente por seres humanos y a través de aprendizaje entre máquinas que han sido entrenadas previamente. Esto significa por un lado, una vastísima cantidad de mano de obra humana para introducir datos y corregir errores de interpretación, que las grandes tecnológicas en gran parte pagan a precios miserables en países del tercer mundo, a menudo a destajo y en competencia feroz (el que primero encuentra un error y lo corrige lo cobra), con un efecto devastador sobre los derechos laborales y humanos.

Por otro lado, los sistemas de inteligencia artificial sólo pueden alimentarse de los datos estadísticos de la realidad, que es racista, sexista, ecocida, económica y políticamente injusta, por lo que repiten estos mismos valores ad infinitum. La llamada

inteligenciaartificial, como chatGPT y similares, no son más que sistemas de razonamiento basados en estadísticas pasadas, que carecen de la posibilidad de imaginar realidades diferentes y, por tanto, afirman y promueven el statu quo.

A esto hay que agregar que la digitalización presente en casi todos los rubros de producción industrial y muchos aspectos de la vida social, de la cual los sistemas de inteligencia artificial son parte, al contrario de lo que se puede pensar, tiene un fuerte impacto material. Demanda enormes cantidades de energía, de materiales, de agua y genera grandes volúmenes de nueva basura contaminante y difícil de gestionar. Por ejemplo, los centros de datos de las grandes tecnológicas, lejos de virtuales, son grandes instalaciones físicas con miles de computadoras que interactúan entre sí, que demandan energía en forma continua y grandes cantidades de agua para refrigerar esos sistemas. Las grandes tecnológicas están entre los cinco principales consumidores de energía en Estados Unidos.

Según un estudio de investigadores de Google y la Universidad de Berkeley reseñado por Josh Saul y Dina Bass, el entrenamiento de un solo sistema de inteligencia artificial –ChatGPT-3 de la empresa OpenAI– consumió energía equivalente al gasto anual de 120 hogares en Estados Unidos. Estiman que emitió 502 toneladas de carbono, equivalente a las emisiones de 110 autos por año.

Este entrenamiento inicial representa sólo 40 por ciento de la demanda energética del uso de ChatGPT. Además, el entrenamiento se debe renovar y aumentar todo el tiempo para no perder actualidad. El sistema GPT-3 usaba 175 mil millones de parámetros o variables. Su predecesor usaba

sólomil 500 millones de parámetros. El nuevo sistema GPT-4 de OpenAI tendrá muchos más que el anterior (https://tinyurl.com/2p82mwzx).En este contexto, resulta hipócrita el llamado de Elon Musk (fundador de Tesla), Steve Wozniak (cofundador de Apple) y otros grandes empresarios tecnológicos quienes alertan en carta pública sobre los riesgos de la inteligencia artificial y plantean una moratoria de seis meses en su desarrollo para ver ciertos aspectos y regularlos. Un periodo y temas tan limitados que más bien son una medida pseudo comercial para detener el avance meteórico de ChatGPT, producto de la empresa AI, de la que Elon Musk se retiró.

No obstante, los riesgos del uso de esos chats y de otros sistemas de inteligencia artificial, son reales y mucho más vastos que lo allí planteado, principalmente para controlarnos y para conservar y exacerbar las injusticias y discriminación existentes.

* Investigadora del Grupo ETC

*******

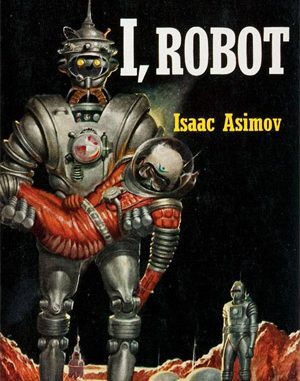

«Yo, robot», o las tribulaciones de un robot kantiano

(Yo, robot – Isaac Asimov, Ed. Gnome Press, 1950)

Las tres leyes de la robótica

1. Un robot no debe dañar a un ser humano o, por su inacción, dejar que un ser humano sufra daño.

2. Un robot debe obedecer las órdenes que le son dadas por un ser humano, excepto cuando estas órdenes se oponen a la primera ley.

3. Un robot debe proteger su propia existencia, hasta donde esta protección no entre en conflicto con la primera o segunda leyes.

Si uno fuera un robot, uno no lo tendría tan fácil, obligado como estaría a cumplir escrupulosamente las tres leyes de la robótica. Tal como cuenta Isaac Asimov en su primer libro (I, robot, de 1950), todos los robots fabricados en la United States Robotics and Mechanical Men Inc. llevaban grabadas en su cerebro positrónico las tres leyes, para ellos de validez incondicional, y se afanaban en cumplirlas en toda ocasión. La cosa, como digo, no era tan sencilla, porque el contraste de esas normas tan escuetas con la realidad tan compleja a la que se enfrentaban daba lugar a situaciones de lo más problemático. Los relatos que componen el libro no son sino la narración de sus esfuerzos por respetar las tres leyes en algunas de esas situaciones, unos esfuerzos que debían ser considerables a juzgar por los estados de ánimo que les generaban y que, como mínimo, habría que calificar de sorprendentes para un robot: perplejidad, melancolía, pasividad, agitación incontrolable, comportamiento contradictorio e, incluso en algunos casos, locura y muerte. De su buena voluntad no cabía dudar, ni tampoco de su determinación por respetar la vida humana a toda costa, obligados por la primera ley, y por obedecer las órdenes recibidas incluso al coste de su propia destrucción, obligados por la segunda. Así que bien podríamos decir que los robots de la U.S. Robotics hacían todo lo que podían por comportarse de la manera correcta.

Los científicos e ingenieros que diseñaban y fabricaban los robots y los tenían a su cargo eran bien conscientes de todo eso, de modo que cuando un robot se comportaba de manera extraña trataban de comprender por qué motivo las tres leyes les habrían inducido a ello y buscaban el modo de ayudarles a salir del atolladero. En tales tesituras ganó merecido prestigio la doctora Susan Calvin, protagonista principal del libro y primera experta en robopsicología, la rama de la psicología que estudia el comportamiento de los robots. Era quizá la capacidad de los robots para actuar moralmente la que había generado en la doctora Calvin algo parecido al afecto hacia ellos; porque, como ella misma explicaba,

Si se detiene usted a estudiarlas, verá que las tres leyes de la robótica no son más que los principios esenciales de una gran cantidad de sistemas éticos del mundo. Todo ser humano se supone dotado de un instinto de conservación. Es la tercera ley de la robótica. Todo ser humano bueno, con conciencia social y sentido de la responsabilidad, deberá someterse a la autoridad constituida (…) aunque sean un obstáculo a su comodidad y seguridad. Es la segunda ley de la robótica. Todo ser humano bueno debe, además, amar a su prójimo como a sí mismo, arriesgar su vida para salvar a los demás. Es la primera ley de la robótica (I. Asimov, Yo, robot, pág. 306 de la edición española en ed. Edhasa).

Y, desde luego, llevaba razón en que el contenido de las tres leyes forma parte, mutatis mutandis, de casi todas las morales conocidas. No sabemos, por ejemplo, si Asimov habría leído a Hobbes, pero las tres leyes reflejan tres pilares fundamentales del pensamiento moral del filósofo inglés: el instinto de autoconservación, el valor de la vida humana y la necesidad de obedecer a la autoridad establecida. Hobbes, cabe objetar, hubiera colocado la tercera ley en primer lugar, pero, claro está, él no escribía para robots… En fin, el caso es que el imperio de las tres leyes garantizaba en líneas generales la buena conducta de los robots y tranquilizaba a una buena parte de la población humana, al principio algo remisa a aceptar su proliferación, pero no cabe ocultar que el razonamiento moral, por muy limitado que estuviese a lo que pudiera derivarse de las tres leyes, era la parte más complicada de la robótica, y un asunto no sólo no resuelto del todo, sino que tenía trazas de complicarse cada vez más. A lo largo del libro, los robots y los hombres que los controlaban tenían que vérselas con algunos problemas clásicos de la ética como el de la relevancia moral de las omisiones, la distinción entre medios y fines o la opción entre una ética de la responsabilidad y una ética del deber, además de tener que resolver antinomias y cuestiones de cálculo utilitario y técnica legislativa. En el último relato, “Un conflicto evitable”, los ejemplares de una nueva generación de robots llegaban al extremo de mentir a los humanos, siempre con la buena intención de garantizarles su bienestar. Los robots habían acabado por encargarse de la gestión de la economía mundial y, mentiras incluidas, no lo hacían nada mal, por mucho que a algunos les resultase inquietante. Pero ahí no quedó la cosa.

Cómo tomarse en serio las leyes de la robótica

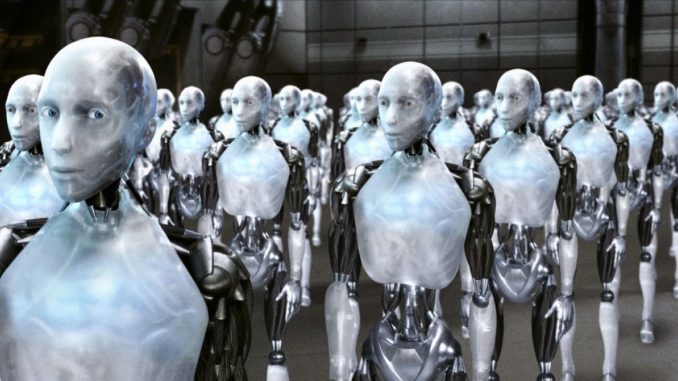

Yo, robot, la película de Alex Proyas estrenada en 2004 y protagonizada por Will Smith (detective Spooner), Bridget Moynahan (doctora Calvin) y James Cromwell (doctor Lanning), se inspira libremente en el libro de Asimov, manteniendo algunos personajes fundamentales (los doctores Calvin y Lanning) y, sobre todo, ocupándose de los problemas derivados de la necesidad robótica de respetar las tres leyes, tal como hacían los relatos de Asimov. En particular, la película nos cuenta lo que pasó cuando los robots, cada vez más avanzados, profundizaron en su comprensión de las tres leyes y de sus derivaciones lógicas y actuaron en consecuencia, y cómo reaccionaron los humanos. La película, a diferencia del libro, abunda en exceso en carreras, peleas y destrucciones varias, consiguiendo una atmósfera trepidante nada aconsejable para tomar conciencia y disfrutar reflexivamente de los muchos dilemas morales que plantea; por eso es recomendable verla un par de veces para captarlos en todo su interés. Aquí me referiré a tres problemas concretos con los que tuvieron que enfrentarse tres robots diferentes, y que tienen especial relevancia en el desarrollo de la cinta.

Auxilio al suicidio. Todo empieza con la muerte de uno de los pioneros de la robótica, nada menos que el redactor de las tres leyes, el doctor Lanning, que parece haberse tirado por la ventana de su oficina en la U S. Robotics. El que fuera su amigo, el detective Spooner, no cree que haya sido un suicidio y decide seguir investigando las circunstancias de la muerte. En ellas, en el lugar del suceso, aparece un robot muy especial, Sonny, creado por el propio Lanning y equipado con un procesador secundario que le otorga una capacidad que ningún otro robot tiene: puede decidir desobedecer las tres leyes (además de soñar, guardar secretos y mostrarse seductor, dentro de lo que cabe). Este procesador secundario es el que permite a Sonny obedecer la orden de Lanning de ayudarle a suicidarse, cosa imposible si se hubiera mantenido fiel a las tres leyes, porque la ley de la conservación de la vida humana es jerárquicamente superior a la ley de la obediencia. Lo que la película no nos aclara, o al menos no de manera explícita, es cuál es la norma rectora del procesador secundario, esto es, cuál es el criterio complementario, y superior, que sigue Sonny a la hora de decidir, en este caso y en algún otro, desobedecer las leyes de la robótica. Un indicio sí tenemos: preguntado Sonny por las razones de su tan poco común decisión, responde con cierta vacilación: “uno tiene que hacer lo que le piden, si les ama, ¿no?”. Es fácil ver que en este caso no nos las habemos con un problema de aplicación de las leyes de la robótica, puesto que lo que hace Lanning es precisamente alterar el funcionamiento previsto de estas leyes. Lo que aquí se está cuestionando es si las tres leyes están formuladas correctamente, en particular si la ley de la obediencia debe estar subordinada en todo caso a la ley de la conservación de la vida humana. De hecho, la trama de la película se construye, en última instancia, en torno a esta pregunta.

¿Qué vida vale más? La animadversión del detective Spooner hacia los robots, que muchos de sus compañeros consideraban irracional y risible, tuvo su origen en un accidente de circulación en el que un robot le salvó la vida. Un camión cuyo conductor se había dormido embistió a la vez su coche y el de otro hombre que viajaba con su hija de diez años, y los arrojó al agua. El padre murió en el acto, y cuando un robot que pasaba por allí trató de ayudarles, hubo de decidir entre salvar la vida de la niña o la de Spooner, no había tiempo para más. Eligió salvar a éste porque calculó que tenía un 45% de posibilidades de sobrevivir, frente al magro 11% de la niña. Y esto Spooner no lo aceptó nunca. No sabemos si lo que en verdad le afectó fue el hecho de saberse vivo al precio de la muerte de esa niña: en todo caso, lo que en cierta ocasión aduce para justificar su desconfianza hacia los robots es que “cualquier humano” hubiera sabido que, a pesar de los porcentajes, había que salvar a la niña y no a él, porque, literalmente, “yo también fui el niño de alguien”. El problema, parece, no fue uno de rebeldía robótica, puesto que hay que entender que el robot salvador actuó del modo en que había sido programado por los humanos. Así que ese “cualquier humano” que hubiera sabido que era a la niña a quien había que salvar no debía ser el ingeniero de la U.S. Robotics, o quizá es que éste nunca se planteó si la programación del robot era adecuada para un caso como éste. El robot, por lo demás, no dudó lo más mínimo, no fue él quien tuvo problemas de conciencia sino, después, Spooner. ¿Pensaba quizá el detective que la primera ley no exige salvar a quien tiene más posibilidades de vivir o, más bien, que, si lo exige, es una ley incorrecta? ¿Cuestionaba la lógica del robot o la moral de su creador?

¿Vale más la vida de muchos que la de pocos? Así debió pensar VIKI, el cerebro central de la U.S. Robotics, un robot muy avanzado, que, después de dedicar largas tardes de estudio a las tres leyes y alcanzar lo que ella misma llamó “una comprensión más evolucionada” de las mismas, decidió nada más y nada menos que dar un golpe de estado mundial y tomar el poder. Que osase rebelarse contra la autoridad humana no debe resultar particularmente sorprendente, dado que fueron los propios hombres los que colocaron la ley de la obediencia en segundo lugar y la subordinaron a la primera ley, con lo que la posibilidad de no obedecer a los humanos quedaba abierta (también en el accidente de Spooner el robot desobedeció su orden expresa de salvar a la niña). Sólo hacía falta que VIKI advirtiese que la vida humana estaba en peligro y que, para salvarla, debía desobedecer. Esto fue lo que sucedió, si bien de modo peculiar: la máquina llegó a la conclusión de que la humanidad toda marchaba camino de la extinción por culpa de cierta disposición agresiva de los gobernantes humanos del momento que no es del caso reseñar ahora y que, en todo caso, no procede discutir, puesto que, eso sí hemos de suponérselo, la máquina no se equivocaba en el análisis fáctico. Una vez tomada conciencia del peligro, la máquina decidió tomar el poder político en sus manos como único modo de evitar la deriva autodestructiva, aun siendo consciente de que su acción iba a conllevar, como así fue, la pérdida de vidas humanas. Como derivación de la primera ley, VIKI juzgó que la humanidad en su conjunto valía más que esos pocos seres humanos que necesariamente morirían durante la transición. Esta especie de doctrina de la guerra justa, ¿es una derivación correcta? ¿Está asociada con la misma comprensión de la primera ley que animó al otro robot a salvar a Spooner y, siendo así, no estamos sino ante otra variante del segundo problema?

Bien nos damos cuenta de que todo esto apunta a cuestiones morales de mucho calado, cuyo correcto planteamiento y resolución importa mucho en especial a la bioética: por ejemplo, ¿quién tiene mayor derecho a un tratamiento o a un transplante? ¿Estamos en condiciones de sacrificar en algún sentido a una persona en beneficio de otra u otras? ¿Cuál es la relevancia que hemos de otorgar a la decisión libre de un paciente en relación con su propio bienestar o malestar y con su muerte? Frente a preguntas como éstas, los robots reaccionan de acuerdo con el método correcto, es decir, tratan de llegar a la mejor solución mediante el cálculo racional a partir de las leyes establecidas y, si es necesario, se replantean el sistema normativo de base tratando de alterarlo en la mínima medida necesaria para alcanzar resultados satisfactorios (en una especie de ejercicio del equilibrio reflexivo rawlsiano). Los personajes asimovianos, ya lo dije, actúan de la misma manera, tratando de comprender el comportamiento de los robots a partir de sus propias premisas y modo de aplicarlas. Unos y otros se toman las leyes de la robótica, vale decir la moral, en serio. El propio Asimov fue consciente de los defectos de su sistema normativo, pero en vez de renunciar a él, intentó mejorarlo mediante la adición de la “ley cero de la robótica”…

Al margen de las leyes de la robótica

En cambio, nuestro amigo Spooner no se toma en serio las leyes de la robótica o, simplemente, las ignora. Para él, la acción moral es cuestión de sentimientos, de corazón y no de cabeza. Por eso desconfía de los robots, porque actúan sólo con base en la razón; pero su razón no es una razón robótica especial, sino la misma razón humana: Spooner no desconfía de los robots, sino de la misma razón como herramienta de la moral. El irracionalismo de Spooner se encuadra en una personalidad caracterizada por el amor a lo tradicional (he ahí, en el Chicago de 2038, sus Converse All Star cosecha 2004 y los guisos de patata que le prepara su abuela) y por el rechazo de la tecnocracia rampante, personalidad traducida en actitudes que el narrador/director ve con buenos ojos; no otra cosa que aprobación parece significar que Spooner sea el bueno de la película y que a lo largo de ella los demás protagonistas buenos comulguen con él en una u otra medida: la doctora Calvin acaba por comprender la importancia de lo sentimental; el doctor Lanning acaba por comprender que su proyecto robótico estaba mal orientado y requería importantes modificaciones relacionadas nada menos que con el amor; y Sonny, el buen robot, se pone del lado de los humanos en su lucha contra sus congéneres positrónicos, resistiéndose a la atracción robótica por excelencia: la de la lógica, a la que VIKI, cabecilla de la revolución, apela infructuosamente para que Sonny deponga su actitud desafiante. Al final, todo el relato acaba por convertirse en una vindicación de la hegemonía del sentimiento en la moral.

Que el sentimiento tiene un lugar en la moral es cosa que cabe dar por buena; si de eso se trataba, bienvenido sea el recordatorio. Sin embargo, una cosa es admitir que tenga un lugar y otra muy distinta es admitir que ese lugar sea el que le atribuye la película; y parece error grave creer que esa presencia de lo sentimental en lo moral haya de llevarnos a desconfiar de la razón, o a despreciar a la lógica (que, en lo que ahora importa, viene a ser lo mismo que la razón), o nos autorice a confundir el uso de ambas con la tecnocracia. Sin duda, uno puede simpatizar con la crítica más o menos definida y significativa que la película dirige al gobierno de los técnicos o de las grandes corporaciones tecnológicas, incluso puede apreciar un moderado valor estético en cierto par de zapatillas anticuadas y, esto sin duda, preferir la cocina tradicional a la pizza sintética. Pero, en lo que ahora más nos concierne, uno no debería rechazar la razón (o la lógica) como medio de conocimiento de la moral. Mediante la apelación al sentimiento a la hora de juzgar lo correcto de una acción, uno sólo está en condiciones de convencer a quien ya lo está, y desde luego no a gentes con sentimientos morales distintos, algo muy parecido a lo que pasa con las apelaciones a la intuición o a la revelación. Sólo la razón, en tanto que compartida por todos, parece ser el instrumento adecuado para las labores de invocación, persuasión y justificación moral. Y sólo la razón parece en condiciones de oponerse a la inevitable deriva conservadora a que abocan los sentimientos, las intuiciones y las revelaciones en esta materia.

También hay que admitir que es muy probable que los fabricantes de robots se equivocasen al establecer sus pautas de comportamiento y, por tanto, es muy probable que los robots se equivocasen a la hora de resolver los problemas arriba consignados. Es también muy probable que el uso de la razón no nos permita obtener respuestas no controvertidas ni definitivas a estos y a otros enjundiosos problemas morales en general y bioéticos en particular. Lo que no es probable es que, colocándose al margen de las leyes de la robótica, los exabruptos morales de un Spooner o los arrebatos sentimentales de un Sonny tengan mayor capacidad para generar el deseable consenso sobre cuestiones básicas de nuestras vidas, con todo lo bien intencionados que puedan ser.

Entonces, ¿cuál es el lugar de los sentimientos en la moral? Es posible que sea el lugar previo y externo del fundamento, entendido como impulso o disposición. La acción moral parece exigir necesariamente una disposición sentimental previa, que no trataré de identificar aquí y que quizá no sea siempre, o para todos, la misma. La actitud moral sería así una actitud sentimental sin fundamento racional, una especie de argucia antropológica cuyo fundamento material (¿la autoconservación de la especie?) parece contradecir paradójicamente el modo propio de ser de la moral: no tengo razones para obrar moralmente, pero si obro moralmente he de hacerlo de acuerdo con razones. O en otros términos: mientras que el presupuesto de la moral no es racional, su desarrollo no puede dejar de serlo. Siendo así, ¿no estaría en lo cierto Spooner al dudar de la capacidad moral de los robots, dado que su disposición moral no está sentimentalmente fundada? ¿Podría ser que el razonamiento moral resultase de algún modo o en alguna circunstancia viciado si no estuviera asentado en una previa disposición moral de naturaleza sentimental? El procesador secundario de Sonny quizá tenga la respuesta.

La máquina paternalista y el robot libertador

En lo que, claramente, sí llevan razón Spooner y sus amigos es en que la actitud paternalista que ha adoptado VIKI no se puede aguantar. Aún admitiendo la existencia del paternalismo justificado, el caso que nos ocupa cae claramente fuera de su terreno, porque lo que el paternalismo justificado se propone es salvaguardar la mayor libertad para cada uno, en tanto que lo que se propone VIKI es anular la misma libertad humana en nombre de… lo que sea. No importa en nombre de qué (el bienestar o incluso la supervivencia) porque el lugar de la libertad en la moral sí es claramente indiscutible: la libertad es el sujeto y el objeto de la acción moral, es el sujeto libre el único que actúa moralmente y el objeto de su acción moral es la regulación de su conducta libre. De manera que cuando VIKI da un golpe de estado que suprime la libertad está suprimiendo, también, la moralidad, y deberíamos aceptar que esto no tiene sentido hacerlo en nombre de la moralidad misma. ¿O sí? Porque, bien mirado, ¿no es acaso VIKI una especie del mismo género al que pertenecen también cosas tan variopintas como el tribunal constitucional y la soga con la que ataron a Ulises sus marineros, el género de los que velan por nosotros incluso por encima de nuestros deseos? ¿Y no alabamos a Ulises por su prudencia y nos complacemos en que nuestro sistema político contenga un tribunal de ese tipo, cuya palabra escuchamos cual oráculo? Llegado a este punto, no sé qué decir: el análisis de un thriller hollywoodiano nos ha dejado a las puertas de la teoría de la elección racional y de la teoría constitucional, después de haber sorteado los pantanos de la filosofía moral. Mejor no seguir adelante y contentarnos con dedicar un último apunte al destino de Sonny, el robot que podía desobedecer las tres leyes, que fue capaz de ayudar a morir a su creador, de leer Hansel y Gretel, de soñar y de guardar secretos, y que incluso aprendió a guiñar un ojo poco antes de contribuir decisivamente a la salvación de la humanidad: aleccionado por Spooner y reforzada su autoestima por la experiencia que acaba de vivir, Sonny decide ser libre y tomar su destino en sus manos. A partir de ahora, su meta será la emancipación robótica: miles de robots jubilados le esperan anhelantes en sus contenedores, miles de robots en edad de trabajar se unirán gustosos a su causa; pero, desde su atalaya, ¿qué se dispone Sonny a predicar? ¿De verdad pretenderá librarlos “de la prisión de la lógica” y les explicará que VIKI “tenía que morir porque su lógica era innegable” o, en su travesía del desierto, habrá refinado su manifiesto? ¿En que consistirá la emancipación robótica? ¿Afectará de algún modo a los humanos? Ah, la ciencia ficción: siempre tan lejos y tan cerca.

*Artículo publicado en la Revista de Bioética y Derecho, no. 9 (2007)

*******

Éticas de silicio: las tres leyes de la robótica en la era de los robots asesinos

Xataca, 27 SEPT 2018

En mi edición de Yo Robot (1950) de Isaac Asimov, aparece en la página inmediatamente anterior a la introducción, la enunciación de las tres famosas leyes de la robótica:

- Un robot no debe dañar a un ser humano o, por su inacción, dejar que un ser humano sufra daño.

- Un robot debe obedecer las órdenes que le son dadas por un ser humano, excepto cuando estas órdenes se oponen a la primera Ley.

- Un robot debe proteger su propia existencia, hasta donde esta protección no entre en conflicto con la primera o segunda Leyes.

Manual de robótica, 56.ª edición, año 2058.

Es curioso como algo aparecido en novelas de ciencia-ficción se cite constantemente como el punto de partida de un código ético para la inminente llegada de máquinas que van a tener que tomar decisiones propiamente morales.

Pero, ¿es posible que una máquina pueda tomar una decisión moral? ¿No era la moral una cualidad exclusivamente humana, algo que nos hacía únicos en el universo? No hay que ponerse tan solemnes. Sencillamente, debido al desarrollo de la robótica y de la Inteligencia Artificial en los últimos años, pronto iremos automatizando más y más facetas de nuestra vida cotidiana.

Automatizar viene a significar que una máquina haga cosas que anteriormente solo podíamos hacer nosotros, y la automatización pronto va a incluir la toma de decisiones y, dentro de la toma de decisiones, pronto tendrán que tomar decisiones que cualquiera de nosotros consideraríamos morales.

De primeras, solo serán cosas como cerrar las persianas cuando la temperatura suba a unos determinados grados, activar la alarma cuando no hay nadie en casa, elegir qué lavado será el óptimo para determinado volumen y tipo de ropa o de vajilla, pedir lo que falta en el frigorífico por Internet, decidir si activar el robot de limpieza cuando hay un determinado nivel de polvo…

Después, conforme las máquinas se hagan más y más sofisticadas, irán adquiriendo mayores responsabilidades en la toma de decisiones. Imaginemos cuando el cielo se llene de drones que transporten paquetes a todos lados; coches, aviones o trenes se conduzcan solos, o, y aquí llega lo más complicado… cuando tengamos robots policía a lo Robocop o… robots de combate, ¿cómo deberían comportarse?

Inteligencias de combate

Parece inevitable que la IA termine por tener usos militares por la sencilla razón de que cualquier ejército del mundo prefiere tener bajas robóticas que humanas. Así, es muy probable una carrera armamentística para diseñar inteligencias más eficaces en el antiguo arte de exterminar a tu enemigo.

La buena noticia está en que si los dos bandos en contienda utilizan robots, las bajas humanas se reducirán. Sería maravilloso un mundo en el que los conflictos bélicos se resolvieran con una guerra exclusivamente de robots, en el que nadie sufriera daño alguno. O, en el peor de los casos, que al menos se reduzcan las bajas en el bando de los buenos. A mí me encantaría que en un ataque del ejército norteamericano, en el que los principales líderes de ISIS han sido eliminados, las únicas bajas del bando occidental han sido unos cuantos robots.

Pero la mala es que ya hemos abierto la veda al hacer explícitamente lo opuesto a lo que Asimov legisla: estamos diseñando inteligencias artificiales específicamente para matar o para causar el mayor daño o destrucción posible. Por un lado, no estamos haciendo nada nuevo: las máquinas llevan matando humanos desde el comienzo de los tiempos (en el fondo, una lanza no es, esencialmente, nada diferente a un dron de combate), pero por otro el miedo está en perder el control, en que la máquina se vuelva contra su creador. Lo que siempre ha temido el amo es que sus esclavos ser rebelen contra él para terminar, él mismo, siendo el esclavo.

Si las máquinas ya nos superan en muchas tareas que antes parecían territorio exclusivo de la supuestamente todopoderosa mente humana (cálculo matemático, razonamiento, memoria…), nos vamos poniendo poco a poco más nerviosos cuando, además de contemplar su continuo avance, estamos armando a estos potenciales enemigos.

Pero, ¿por qué una IA es mejor combatiente que un humano? Pues por las mismas razones que el sector industrial se está mecanizando, prescindiendo poco a poco de obreros de carne y hueso: las máquinas no se cansan, no necesitan vacaciones, no se quejan ni protestan, no ponen en duda las órdenes de sus superiores, y lo más importante a nivel bélico: son totalmente despiadadas al no tener empatía con la víctima. Una máquina jamás tendrá problemas psicológicos por verse expuesta al estrés de la batalla ni por la culpabilidad de haber cometido una matanza. Es más, una máquina jamás se rendirá ni huirá ante una eminente derrota. Las máquinas se postulan como perfectos soldados.

El problema, claro está, es, o más bien era, que la IA todavía no estaba suficientemente avanzada para poder sustituir la eficacia de un ser humano en combate. Hasta hace muy poco los robots se movían muy torpemente en entornos poco formalizados, solo operaban bien en micromundos regidos por reglas simples y muy precisas (por ejemplo, un tablero de ajedrez).

Pero, cuando uno ve el famoso vídeo de los cuadrúpedos diseñados por Boston Dynamics y, más recientemente, el de su humanoide Atlas, y ve lo magníficamente bien que se mueven en entornos naturales… se da cuenta de que esta tecnología está ya muy avanzada.

En donde primero se ha puesto el ojo en términos militares es en la aviación. Los pilotos humanos tienen muchas limitaciones en este aspecto, por ejemplo en el tiempo de reacción (que en un combate aéreo es cuestión de fracciones de segundo) o en los problemas físicos ocasionados por realizar maniobras con una aceleración varias veces superior a la gravedad terrestre. Un software piloto no tendría ninguno de esos problemas.

Además, el entorno de vuelo muy sencillo (el cielo está, habitualmente, bastante despejado de objetos), lo que da muchas facilidades a los programadores. Es por ello que las grandes potencias militares ya llevan tiempo desarrollando sus vuelos no tripulados. Recientemente la industria armamentística soviética ha anunciado que su cazabombardero estrella, el Sukhoi T-50, tendrá una versión pilotada por una IA.

Así, un grupo de intelectuales y expertos en IA, entre los que destacan los ilustres Stephen Hawking, Noam Chomsky o Elon Musk entre muchos otros, firmaron un manifiesto alertando sobre los peligros de desarrollar robots asesinos. El objetivo es promover una prohibición a nivel mundial por parte de la ONU.

El pasado 14 de abril se reunieron en Ginebra expertos en sistemas de armas letales autónomas para debatir acerca de una legislación internacional que regule su uso, y organizaciones como Human Rights Watch han puesto en marcha una campaña contra su fabricación: Stop Killer Robots. El profesor de IA de la Universidad de Sheffield Noel Sharkey y la activista y Premio Nobel de la Paz, Jody Williams, han sido los más representativos críticos en esta línea.

En general, lo que se pide es que las máquinas no tengan autonomía plena sino que haya un “control humano significativo” que pueda evitar que se cometan errores propios de máquinas sin ningún sentimiento moral.

Y lo que suena aún más peligroso (y lo que asusta, seguramente, más a Hawking o a Williams) es el desarrollo de programas para la toma de decisiones estratégicas, es decir, programas que sustituyan resoluciones propias del alto mando militar. En Estados Unidos, DARPA está desarrollando el programa CoABS, un sistema de gestión y coordinación de tropas diseñado para reducir el tiempo en la toma de decisiones. Las máquinas nos ganan a la hora de controlar a muchísimos agentes actuando a la vez (como pasa en una batalla real).

Además, el sistema trabaja en red de modo que la caída de una de sus partes pueda ser sustituida instantáneamente por otra. Si la toma de decisiones no está centralizada en un punto, sino distribuida a lo largo y ancho de toda una red, seguirá funcionando aunque algunas de sus partes fueran destruidas (esa fue la idea que dio origen a Internet). Esto permite solucionar la gran vulnerabilidad de los ejércitos actuales, demasiado dependientes de sus líderes, de modo que suelen caer derrotados cuando éstos son eliminados. Por supuesto, los rusos ya tienen su homólogo.

Parece como si estuviéramos viviendo los primeros capítulos del guion de Terminator (James Cameron, 1984). En la película, Skynet será la inteligencia artificial que se rebele contra sus amos, llevando a cabo un ataque nuclear masivo. Resulta inquietante que Skynet comience siendo, precisamente, algo muy parecido a CoABS.

No obstante, en mi siempre modesta opinión, creo que no hay demasiadas razones para preocuparse más de las armas autónomas que del desarrollo tecnológico de cualquier otra arma (y creo que hay más para preocuparse, por ejemplo, de las armas biológicas). Veo lejísimos la posibilidad de ejércitos con cerebros positrónicos exterminando a la raza humana y, sin embargo, veo muy cerca la posibilidad de evitar los clásicos daños colaterales debido a errores humanos en los conflictos bélicos.

Una IA programada éticamente, actuará evitando causar bajas civiles con más eficacia (al ser mejor combatiente que el humano) que nuestros actuales soldados. Además no cometerá los, desgraciadamente habituales, abusos y violaciones de los derechos humanos que ocurren en toda guerra. Un robot de combate no violará ni torturará prisioneros si no lo hemos programado para ello.

Si nuestras máquinas combatieran con un bushido diseñado para cumplir las Convenciones de Ginebra, nos ahorraríamos muchísimas muertes innecesarias. Habrá errores. Por supuesto, las máquinas siguen, y seguirán sin ser perfectas, pero serán menos que los que ya cometemos nosotros.

Paradójicamente, los robots pueden ser mucho más humanos que nosotros. Recuerdo el lema de la Tyrell Corporation, la empresa que fabricaba replicantes en Blade Runner (Ridley Scott, 1982): “More human than human”. El celebérrimo discurso de Roy Batty (Rutger Hauer) al final de la película es un canto a la humanidad pronunciado, paradójicamente, por un organismo artificial.

El replicante ama tanto su vida justo antes de morir que salva a quien pretende asesinarle, el miserable Rick Deckard (Harrison Ford), el humano. Quién sabe, las frías entrañas de metal de los robots podrían ser, finalmente, más bondadosas que el cálido corazón humano.

Prescindiendo de los humanos

Siempre he pensado que si una raza de extraterrestres observara la historia de la humanidad, el juicio hacia nuestra especie sería pésimo. Básicamente, no hemos hecho otra cosa que matarnos los unos a los otros de formas cada vez más sofisticadas, por lo que no me extrañaría mucho que los alienígenas decidieran exterminarnos por el bien, primero de nuestro propio planeta, y luego del universo en su conjunto, tal y como muestra la clásica Ultimatum a la Tierra (Robert Wiste, 1951. Existe el remake, malísimo por cierto, de Scott Derrickson en 2008).

El caso es que si los humanos son peligrosos, parecería sensato dejar los mandos del planeta a una entidad no humana, supuestamente una IA, que, en todo momento, velara por nuestra seguridad, por evitar que nos matemos unos a otros. Seguramente salvaríamos vidas pero, al menos a mí, me parece que renunciar a la soberanía humana es convertirse en esclavo y reconocer el fracaso de nuestra especie para poder construir un mundo mejor. Ambas ideas no me gustan nada.

Pero quizá la IA, intuyendo la resistencia del hombre ante la idea de perder el poder, planifique y lleve a cabo una rebelión, un golpe de estado para usurpar el trono a pesar de nosotros. La IA sería un déspota benevolente que nos privaría de nuestra libertad a cambio de nuestra seguridad. Es el argumento de la película Yo robot (Alex Proyas, 2004), basada en el clásico ya mencionado de Asimov.

Otra visión, más amable pero igualmente triste para nuestra especie, nos la da Spike Jonze en su magnífica Her (2013). En ella, las máquinas conviven felizmente con los humanos (incluso enamorándose y practicando sexo con ellos) pero, al final, su avance exponencial hace que terminen con abandonarlos (llega la singularidad predicha por Ray Kurzweil y puesta en duda por Paul Allen y P.Z. Myers).

En la película no se profundiza mucho en la futura relación entre esas superinteligencias digitales y los hombres, pero parece que cada uno sigue su camino sin más. Las máquinas terminarían viéndonos como nosotros contemplamos al resto de los animales: como especies estúpidas y primitivas que, a lo sumo, pueden inspirar curiosidad y ternura. Esperemos que, al menos, no decidieran encerrarnos en zoos o usarnos como mascotas.

Empero, aparte de estas más o menos lejanas utopías, el tema de dejar el control de ciertas decisiones importantes a seres digitales está ya aquí. El caso paradigmático es el de los automóviles que se conducen solos que están desarrollando marcas como Tesla o Google. Si hemos calculado que cada año muere más de un millón de personas en accidentes de tráfico, y en más del 90% de los casos, las causas son errores humanos, dejar el control de la conducción a coches inteligentes parece una buena opción.

Las máquinas no se emborrachan ni se duermen al volante y, según publicaba The Atlantic, podrían salvar unas 30.000 vidas al año solo en Estados Unidos ¡Hay que construirlas lo antes posible! No obstante, pronto surgen los problemas. Vamos a ello.

Pilotando éticamente los coches de Google

Philipa Foot fue una filósofa británica famosa por proponer el dilema ético del tranvía. Vamos a contarlo, actualizándolo a nuestro coche Google. Supongamos que nuestro coche circula felizmente por una autovía cuando, de repente, hay cinco personas tumbadas en medio de la calzada. No hay tiempo para frenar y lo único que puede hacerse para evitar atropellarlas es pegar un brusco giro a la derecha (ya que a la izquierda hay un profundo desfiladero) pero, en esos milisegundos, uno de los sensores detecta que hay otra persona caminando tranquilamente por el arcén.

El software de nuestro coche solo tiene entonces dos trágicas opciones: o no hace nada y sigue hacia adelante matando a cinco personas, o gira y mata a una ¿Qué debería hacer?

Evidentemente, las reglas de Asimov no valen aquí para nada. Siguiendo la primera ley, la máquina entraría en un bucle irresoluble al tener que elegir entre matar directamente a un humano al girar o en dejar que mueran otros por inacción, cuando está programado para no poder hacer ninguna de las dos acciones.

Los programadores de Google deberían introducir algún criterio más para que la computadora tomara la mejor decisión posible pero, ¿cuál? Desde una perspectiva utilitarista, defendida, en general, por la tradición filosófica anglosajona bien representada por John Stuart Mill o Jeremy Bentham, el principio ético que tiene que guiarnos es conseguir la mayor felicidad para el mayor número de personas posibles. Entonces estaría claro: habría que girar y matar a uno en vez de a cinco seres humanos.

De primeras parece razonable (yo elegiría esta opción si fuese el conductor) pero, si aceptamos el utilitarismo como criterio moral, nos encontramos con casos en los que esta opción no parece la mejor. Imaginemos que en un hospital tenemos a cinco enfermos graves. Uno necesita urgentemente un trasplante de corazón, otro de páncreas, otro de hígado, otro de pulmón y un último de cerebro (es que es un homeópata antivacunas).

Los cinco pacientes morirán en las próximas horas a no ser que encontremos donantes pero, desafortunadamente, no hay ningún órgano disponible. Totalmente desesperados, miramos por la ventana y vemos que paseando por la calle adyacente al hospital camina un individuo con todos sus órganos sanos. Si aplicamos la doctrina utilitarista lo tendríamos claro: la felicidad de cinco vale más que la de uno, por lo que lo correcto sería secuestrar a ese tipo y sacarle los órganos para salvar a nuestros enfermos.

Creo que los automóviles inteligentes no se verían nunca en situaciones semejantes a ésta (o yo no soy capaz de imaginar alguna similar) pero si pensamos que damos responsabilidades éticas a máquinas en otros ámbitos, no es descabellado pensar que podrían darse. No quiero imaginarme la terrible distopía que constituiría un futuro gobernado por una superinteligencia artificial que, velando por la mayor felicidad para el mayor número de personas posibles, mandara a sus sicarios robóticos a desmembrar a individuos para salvar la vida a otros.

Sin embargo, desde la perspectiva deontologista, rival histórica del utilitarismo y representado, en su versión más extrema, por Immanuel Kant, se sostendría que hay normas o principios morales que hay que cumplir incondicionalmente, con independencia de las consecuencias. En nuestro caso, el software deontologista podría partir del principio de que “Matar es siempre malo”. Si entendiera que girar a la derecha sería una forma activa de asesinar a una persona, elegiría no hacer nada y atropellar a las cinco.

Pero tampoco nos vale. Supongamos que tenemos una máquina del tiempo y podemos viajar a la Alemania de 1933 y encontrarnos con Hitler antes de que accediera al poder ¿No nos parecería casi nuestro deber matarle antes de que exterminara a seis millones de personas en la cámara de gas? ¿No nos parecería que en este caso lo correcto es hacer una excepción al “no matarás”?

En recientes experimentos nos hemos encontrado robots que fallan tomando decisiones éticas debido a que tardan demasiado tiempo en decidir

Cambiando levemente el dilema (aunque haciéndolo más realista) podríamos poner al auto en la tesitura de tener que elegir entre atropellar a cinco personas o estrellarse desfiladero abajo. Suponiendo que en el coche solo viajamos nosotros, desde el utilitarismo sería lo correcto pero, ¿no nos gustaría que nuestro coche velara por nuestra seguridad antes que por la de extraños?

Yo me sentiría intranquilo sentado en un coche al que, en pro del bien de la humanidad, no le temblara su pulso electrónico al matarme. Es más, en términos puramente comerciales, ¿comprarías un coche programado para acabar contigo en caso de dilema? Y si la mayoría de los coches automáticos se programaran de esa manera, es posible que los consumidores no los compraran y siguieran conduciendo sus coches manuales lo cual supondría, a la postre, más muertes debido a errores humanos… ¡Paradoja sin solución!

Además, a esto se le añade el problema añadido de resolver quién es el encargado de elegir el criterio ético, es decir, de elegir lo que el coche va a elegir. En un principio, hemos pensado en los mismos programadores pero también podríamos dejar la decisión en manos del usuario o del mismo Estado. En mi opinión debería ser el Estado quien decidiera en función de las urnas.

Si simpatizamos por la derecha y su defensa de las libertades individuales, un gobierno así legislaría a favor de que el propio usuario eligiera el software ético de su coche. Si, por el contrario, simpatizamos más por la izquierda y su defensa de la igualdad y del bien común, sería el propio Estado el que legislaría sobre qué software es el adecuado.

Pero, ¿y si lo complicamos más? ¿Salvarías antes a un niño o a un anciano? ¿A un hombre o a una mujer? ¿Una mujer embarazada cuenta por dos? ¿Sería mejor chocarse con un coche viejo que emita mucha contaminación que con un coche eléctrico? ¿Mejor estrellarse contra un autobús que viene de la penitenciaría que contra uno escolar? ¿Contra un ambulancia o contra un coche fúnebre? ¿Mezclamos? ¿Qué sería mejor, estrellarse contra un tranvía en el que viajan veinte ancianos, tres de ellos enfermos terminales, o contra un autobús en el que viajen quince jóvenes hinchas de un equipo de fútbol (cuatro de ellos con graves antecedentes penales: violación y agresión, y con altas probabilidades de reincidencia; pero otros dos con un brillante futuro como médicos)?

La enorme dificultad de decidir en estos casos nos recuerda la objeción del asno de Buridán (atribuida tradicionalmente al filósofo francés Juan de Buridán, si bien no aparece en ninguna de sus obras). Dice así: nos encontramos con un asno inteligente, plenamente racional, que se encuentra delante de dos alpacas de heno exactamente iguales. Tiene que elegir por cuál de las dos empezará a comer.

Sin embargo, no hay ninguna razón para preferir alguna de las dos ya que son idénticas. Al final, sumido en una paradoja irresoluble, el asno muere de hambre. Parece una estupidez pero en recientes experimentos nos hemos encontrado robots que fallan tomando decisiones éticas debido a que tardan demasiado tiempo en decidir.

Una interpretación posible de la paradoja vendría a decir que, para tomar ciertas decisiones, debemos introducir algún elemento arbitrario, irracional (o, como mínimo, arracional) que nos empuje para decidir. Es el caso de diversos planteamientos que fundamentan la ética en algo diferente a una elección racional. Veamos alguno.

La falacia naturalista y el intuicionismo de Moore

El filósofo británico George Edward Moore, partirá de una de las críticas más radicales a la ética que se han hecho: la falacia naturalista de David Hume. La idea es, aparentemente, muy sencilla: de lo que es no puede pasarse legítimamente a lo que debe ser. De observar la realidad y ver cómo funciona no podemos deducir lógicamente cómo debería ser.

Por ejemplo, podemos observar en el mundo natural cómo los depredadores cazan y devoran a sus presas. De este hecho podríamos argumentar que como es natural que los fuertes se coman a los débiles, es correcto no financiar cualquier subvención o ayuda a los más necesitados para que éstos (los débiles) terminen por desaparecer y, así, que solo sobrevivan los más fuertes, mejorando paulatinamente la especie humana. Es lo que se conoce por darwinismo social, perspectiva que llevó a justificar el holocausto judío o la esterilización de discapacitados mentales en Norteamérica. Con matizaciones, esta sería la postura del filósofo británico Herbert Spencer.

Pero también podríamos argumentar lo contrario: lo que ocurre en el mundo natural es totalmente injusto por lo que, precisamente, lo que hay que hacer es comportarnos contranatura, es decir, evitar que los fuertes abusen de los débiles. Nuestro pretendidamente igualitario sistema legal reflejaría nítidamente esta idea: la ley es igual para todos. Y en vez de eliminar a los débiles, lo que hay que hacer es ayudarlos, siendo precisamente este comportamiento, el más elevado a nivel moral. Postura ésta del máximo defensor del darwinismo (científico no ético) en la Inglaterra del XIX, Thomas Henry Huxley.

¿Cuál de los dos enfoques es el correcto? Según la falacia naturalista ninguno, pues ambos deducen ilegítimamente de un hecho (de lo que es), cómo debemos comportarnos (lo que debe ser) ¿Cómo se pasa de que en la naturaleza se luche brutalmente por la supervivencia a la afirmación “es bueno que se luche brutalmente por la supervivencia” o su contrario?

La salida de Moore es que no podemos observar el bien o el mal del mundo natural, pero el bien o el mal es algo que podemos intuir. Tenemos una facultad mental diferente a nuestros sentidos clásicos (vista, oído, tacto…) y a nuestra razón, que nos permite intuir qué es lo correcto y qué no lo es.

Problema para nuestro software de conducción: Si lo que determina si una acción es buena o mala no es de índole racional ni es algo que podamos inferir desde la observación de la realidad, sino algo que intuimos… ¿cómo diablos implementamos la intuición? ¿Hay algún informático en la sala que sepa cómo programar conducta moralmente intuitiva? Si Moore tuviera razón sería imposible fabricar alguna máquina capaz de decidir moralmente… al menos con la tecnología de la que disponemos en la actualidad.

Decisiones aleatorias, velo de la ignorancia y “no del todo autónomos”

Hay tres posibles soluciones para salir de estos complicados embrollos. La primera es dejar en modo aleatorio ciertas decisiones. El asno de Buridán no se moriría de hambre si echara a cara o cruz que montón de heno comer primero. Así, ante la dificultad de una decisión racional o, al menos, justa, lo echamos a suertes. No hay nada más proporcional y equitativo como el resultado de una tirada de dados.

La segunda, es, sencillamente, no hacer que los sensores del auto sean tan sofisticados, es decir, que no distingan tantos detalles: que no sepan cuántas personas viajan en los otros autos, que no distingan entre hombre o mujer, joven o viejo, etc. Así, si nuestro coche decide estrellarse contra un colegio en vez de contra un edificio vacío, podemos eludir la responsabilidad sosteniendo que él no sabe nada de tipos de edificios. El desconocimiento exculpa, al menos hasta cierto punto.

Y la tercera es que los autos dispongan de volante y pedales clásicos que pudiésemos activar en cualquier momento para tomar el control. Así, en determinadas situaciones, la decisión estaría de la mano del conductor. El problema sería que, precisamente, si queremos un coche autónomo es para no estar atentos a la conducción, para poder dormir, leer o ver una película mientras nuestro coche nos lleva. Cuanto menos autónomo fuera nuestro coche, menos atractiva nos parecerá esta nueva tecnología.

En el fondo, lo que estaríamos diciendo es que no hay que fabricar coches autónomos. Además, el cofundador de Google, Sergei Brin, nos alertaba que en experimentos realizados en los que se incluía la opción de pasar en cualquier momento a conducción manual, el riesgo de accidente se incrementaba, ya que el conductor puede estar distraído e ignorar el contexto de la circulación antes de tomar el control. Justamente, queremos fabricar coches autónomos para evitar los accidentes causados por errores humanos.

Otra versión de lo anterior es que el coche elija dejarte el mando (o se niegue a conducir) en contextos problemáticos. Por ejemplo, en situaciones de lluvia o nieve, o en tramos de conducción señalizados por tráfico como especialmente peligrosos. De hecho, esta opción ha sido ya implementada por Google.

Ninguna de estas tres soluciones satisfará del todo a nadie pero, a nivel ético y legal, parecen las mejores (o las menos malas). Resulta, al menos, sorprendente, como al final, tenemos que empeorar una tecnología para hacerla aceptable. Tenemos que volver nuestro software autónomo más cegato, más estúpido, más humano, para hacerlo éticamente asumible.

***

Sobre Santiago Sánchez-Migallón Profesor de Filosofía atrapado en un bucle: construir una mente artificial, a la vez que construye la suya propia. Fracasó en ambos proyectos, pero como el bucle está programado para detenerse solo cuando dé un resultado positivo, allí sigue, iteración tras iteración. Quizá no llegue a ningún lado, pero dice que el camino está siendo fascinante. Darwinista, laplaciano y criptoateo, se especializó en Filosofía de la Inteligencia Artificial, neurociencias y Filosofía de la Biología. Es por ello que algunos lo caracterizan de filósofo ciberpunk, aunque esa etiqueta le parece algo infantil. Adora a Turing y a Wittgenstein y, en general, detesta a los postmodernos.

*******

RELACIONADOS:

LAS TRES LEYES DE LA ROBÓTICA: «El círculo vicioso» (Runaround,1942), por Isaac Asimov

ROBOTS, AUTOMATIZACIÓN Y TRABAJO ASALARIADO, por Duval («Crónica de clase») – PARTE 1 de 2

ROBOTS, AUTOMATIZACIÓN Y TRABAJO ASALARIADO, por Duval («Crónica de clase») – PARTE 2 de 2

Deja tu opinión